课程简介

总体内容

graph LR 专高四 --> C[Spring Cloud微服务架构*] 专高四 --> T[其它技术] 专高四 --> W[维数公寓] 专高四 --> M[外卖抢单] 专高四 --> Q[企业级测试与解决方案]

Spring Cloud

graph LR C[spring_cloud微服务架构] --注册中心--> Eureka C --负载均衡--> Ribbon C --服务容错--> Hystrix C --声明式远程服务调用--> OpenFeign C --网关--> Gateway C --配置服务--> Config C --消息总线--> Bus C --请求链接追踪--> Sleuth C --状态监控--> Admin C --网关安全--> Security

其它技术

graph LR T[其它技术] T --消息队列--> RocketMQ T --消息队列--> RabbitMQ T --缓存--> Redis T --分布式任务平台--> XXL-Job T --接口测试与调试工具--> PostMan T --压力&&性能--> JMeter

维数公寓

graph LR 维数公寓 --> 合同录入 维数公寓 --> 预约看房 维数公寓 --> 支付中心 外卖服务 --> 外卖抢单

作业:

上传作业内容和效果视频(3分钟左右);

作业检查表:

graph LR 组长 --> 组员 讲师 -- 抽检 --> 学员

参考资料:

时间

作业参考

AOP

概念

- 连接点(Joinpoint): 程序运行中的一个点(方法运行、异常抛出)

- 通知(Advice):(拦截到某连接点后要执行的动作)

- 切点(Pointcut):(选择哪些连接点)

- 切面(Aspect):(切点和通知的组合)

实操

使用熟悉的利用注解定义切点的方法实现。

- 定义注解

@Target(value= ElementType.METHOD)

@Retention(RetentionPolicy.RUNTIME)

public @interface LogAnno {

String action();

}

- 定义切面、切点

@Aspect

@Component

public class MyAspect {

// 切点; 切面;连接点;

@Pointcut("@annotation(LogAnno)")

public void pointCut() {

}

@Around("pointCut() && @annotation(anno)")

public Object process(ProceedingJoinPoint joinPoint, LogAnno anno) throws Throwable {

//

System.out.println("========================");

Object[] args = joinPoint.getArgs();

for(Object object : args) {

System.out.println(object);

}

System.out.println(anno.action());

System.out.println("========================");

return joinPoint.proceed();

}

}

- 方法上添加注解

@GetMapping("/list") //1, 1,2,3,4 加一条后 1,2,3,4,5

@LogAnno(action = "查询合同") // 1,10 2,10

public Result<IPage<Contract>> list(@RequestParam int page, @RequestParam int size) {

System.out.println("查询列表");

}

一,Eureka介绍

注册服务中心

flowchart TD C[服务消费者] --发现--> E[Eureka] P[服务提供者] --注册 --> E[Eureka]

服务消费者 和 服务提供者 都属于 Eureka客户端。

Eureka 就是Eureka服务端。

作用

- 类似于114查号台的作用, Eureka就是114查号台, 服务提供者就是商家,服务消费者就是别的商家或消费者,服务提供者将信息登记到114,服务消费者会去114查询商家的联系方式。

二,搭建Server端(eureka)

具体步骤如下:

1. 添加依赖

在pom中添加依赖

<!--eureka服务依赖-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-server</artifactId>

</dependency>

2. 按开关

//放在启动类上方

@EnableEurekaServer

3. 加配置

#顶格放

eureka:

instance:

ip-address: 127.0.0.1

prefer-ip-address: true

server:

enable-self-preservation: false #是否开启自我保护,防止网络分区故障时删掉微服务

client:

fetch-registry: false #是否从注册中心获取注册表

register-with-eureka: false #是否要注册到注册中心

二,搭建Client端(house,contract等)

搭建步骤:

1.添加依赖

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<!--注册中心(eureka)客户端依赖-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>

2.按开关

//放在启动类上方

@EnableEurekaClient

3.加配置

#顶格放

eureka:

instance:

prefer-ip-address: true # 优先使用ip地址

ip-address: 127.0.0.1 # 使用这个ip

# instance-id: user # 显示实例名称

client:

register-with-eureka: true # 注册到eureka

fetch_registry: true #从服务器获取注册信息

service-url:

defaultZone: http://localhost:8761/eureka/ # 注册中心地址

三,搭建eureka集群

当只有一个Eureka服务的时候,如果这个服务宕机,就会导致整个系统崩溃,所以需要搭建一个Eureka服务集群,提高服务的稳定性。

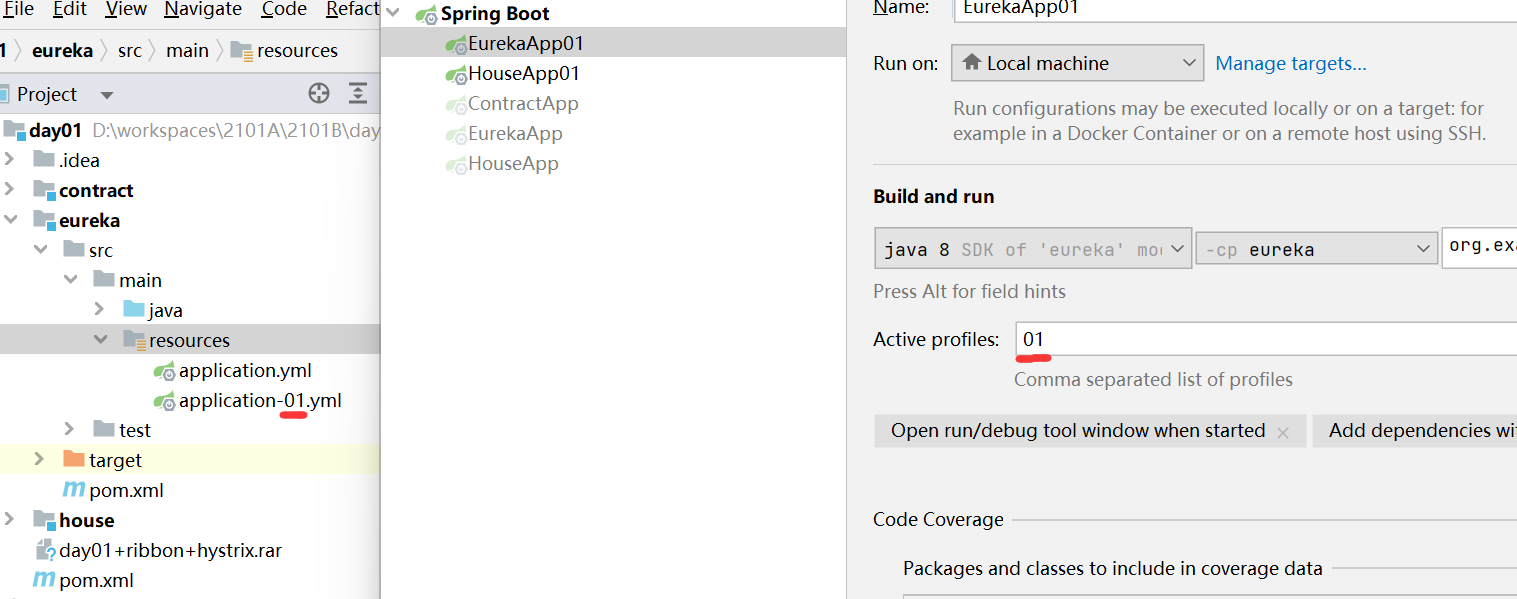

1. 添加配置文件

假设我们要创建两个服务的集群,则先创建两个配置文件,如下:

- application-01.yml

- application-02.yml

然后修改配置中的eureka的配置,修改后如下所示

eureka:

instance:

ip-address: 127.0.0.1

prefer-ip-address: true

server:

enable-self-preservation: false #是否开启自我保护,防止网络分区故障时删掉微服务

client:

fetch-registry: true #是否从注册中心获取注册表; 这里需要获取,所以改为true

register-with-eureka: true #是否要注册到注册中心; 需要注册到注册中心,所以改为true

service-url:

defaultZone: http://localhost:8762/eureka/,http://localhost:8761/eureka/ #两个服务互相指向对方

修改idea的运行配置文件

在IDEA中配置启动入口时,指定要使用的配置文件,例如下面的配置指定使用application-01.yml配置文件。

四,用security保护 eureka

任何用户都可以访问Eureka服务会有安全性隐患,所以一般会在Eureka服务端添加安全保护措施。

加依赖

在Eureka服务的pom中添加依赖。

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-security</artifactId>

</dependency>

配置文件中添加用户名和密码

在Eureka的application.yml文件中添加security配置

spring:

application:

name: eureka

security: # 一定要注意对齐关系,security和application平级

user: # 指定spring security的登录

name: admin

password: 123456

添加安全设置

在Eureka服务中添加以下配置类,放开向eureka的注册请求。

@EnableWebSecurity

public class WebSecurityConfig extends WebSecurityConfigurerAdapter {

@Override

protected void configure(HttpSecurity http) throws Exception {

//csrf -> Cross-Site Request Forgery 跨站请求伪造

http.csrf().ignoringAntMatchers("/eureka/**"); //ignore是忽略的意思

super.configure(http);

}

}

Eureka客户端添加认证信息

格式: 用户名:密码@url

defaultZone: http://macro:123456@localhost:8761/eureka # 注册中心地址

注意,无论是我们示例中的house,contract还是eureka服务本身,只要他想向被security保护的eureka服务端注册都需要带上上面的用户名和密码配置。

其它eureka常用配置

eureka:

client:

register-with-eureka: true #是否将自己注册到eureka服务

fetch-registry: true #是否从eureka服务获取注册信息

service-url:

defaultZone: http://localhost:8761/eureka/ #服务地址,逗号分隔

registry-fetch-interval-seconds: 30 #多久去服务端取一次注册信息

instance:

lease-renewal-interval-in-seconds: 30 #续约间隔,秒

lease-expiration-duration-in-seconds: 90 #过期间隔 ,秒

prefer-ip-address: true #优先使用ip地址而非主机名称

ip-address: 127.0.0.1

server:

enable-self-preservaation: false #开启自我保护

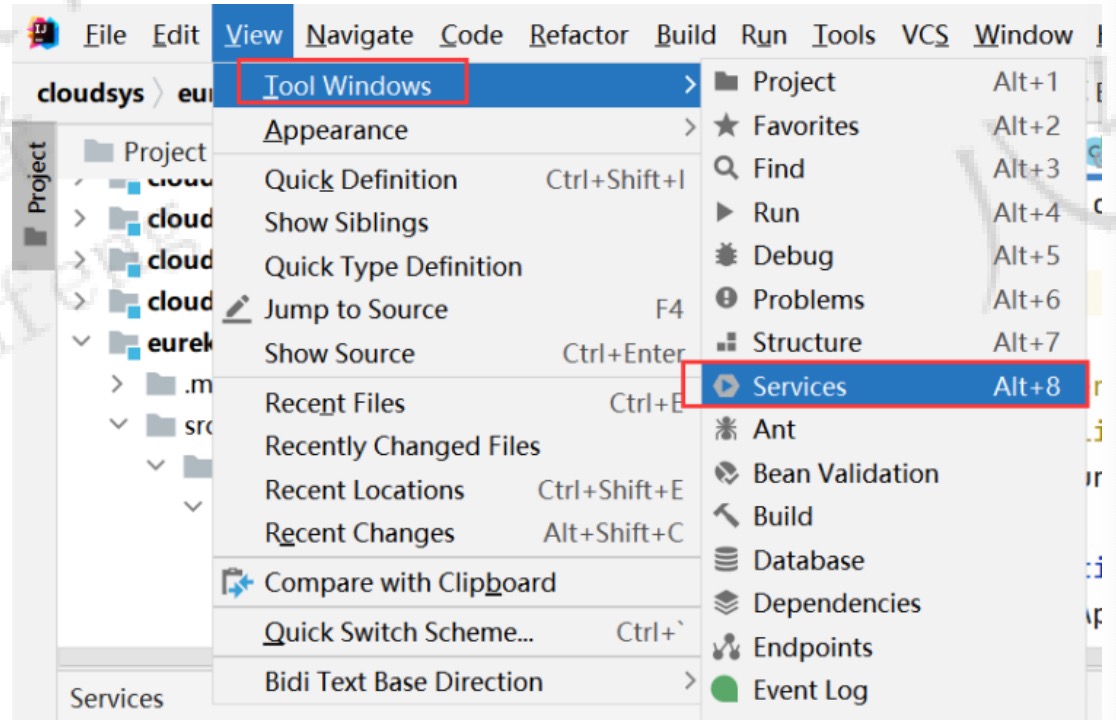

### 打开services面板

打开service窗口:

五、常见错误:

- 添加security配置时,security和application没有上下对齐。

一,RestTemplate

使用之前需要先定义一个RestTemplate的实例,方便别的地方注入:

@Configuration

public class MyRestTemplateConfig {

@Bean

public RestTemplate restTemplate(){

return new RestTemplate();

}

}

之后通过如下方式使用:

// 通过ip地址(域名)直接访问

AllType allType = restTemplate.getForObject("http://localhost:8081/type/", AllType.class);

举个例子:

首先定义一个被调用服务入口,这里是 http://localhost:8081/getName/2

@RestController

@RequestMapping("/")

public class HouseController {

@GetMapping("/getName/{id}")

public String getName(@PathVariable int id) {

System.out.println("====================");

return "房屋id="+id;

}

}

然后在定义了RestTemplate的项目中定义对被调用服务的访问:

@RestController

@RequestMapping("/contract")

public class ContractController {

@Autowired

RestTemplate restTemplate;

//http://ip:port/conteact/test-rest?id=1

@RequestMapping("test-rest")

public String tesRest(int id) {

String forObject = restTemplate.getForObject("http://localhost:8081/getName/" + id, String.class);

return forObject;

}

}

二,Ribbon

微服务架构中会有服务实例间的互相调用,实例之间的远程调用可能需要使用RestTemplate来进行。当被调用的服务部署多个实例后,请求需要公平的发送到这些实例(负载均衡),这时 就需要Ribbon来帮助RestTemplate来实现。

Ribbon 负载均衡策略

- com.netflix.loadbalancer.RandomRule //随机

- com.netflix.loadbalancer.RoundRobinRule //轮询

- com.netflix.loadbalancer.RetryRule //轮询的基础上加上重试

- com.netflix.loadbalancer.WeightedResponseTimeRule //轮询的基础上加上响应时间权重

- com.netflix.loadbalancer.BestAvailableRule //并发最小

- com.netflix.loadbalancer.AvailabilityFilteringRule //过滤掉故障实例,并发最小

- com.netflix.loadbalancer.ZoneAwareLoadBalancer //考虑到区域相同

添加ribbon依赖

<!-- 负载均衡 -->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-ribbon</artifactId>

</dependency>

增加被调用服务的实例

上节课已经配置过Eureka集群(高可用),步骤大致如下:

- 增加配置文件,例如:application-02.yml

- 添加运行入口,右上角 Edit Configuration

- 运行入口中指定使用的配置文件 Active Profiles

使用负载均衡

修改RestTemplate实例定义,增加负载均衡能力。

@Configuration

public class MyRestTemplateConfig {

@Bean

@LoadBalanced //为RestTemplate添加负载均衡能力,

public RestTemplate restTemplate(){

return new RestTemplate();

}

}

修改restTemplate对远程服务的访问方式

将原来对某ip地址的访问改成对服务的访问,restTemplate会在运行时将服务名称改为服务名对应的ip地址。

// 接入eureka和ribbon后, RestTemplate在发起调用前会将type替换为真是的服务器地址

AllType allType = restTemplate.getForObject("http://type/type/", AllType.class);

更换ribon负载均衡算法

@Bean

IRule myRule() {

return new RandomRule();

}

上述代码需要放在 @Configuration修饰的类中。

三,Hystrix - 熔断与降级

hystrix介绍 Hystrix的作用:

- 保护线程资源

//信号量限流

@HystrixCommand(

commandProperties= {

@HystrixProperty(name="execution.isolation.strategy", value="SEMAPHORE"),

@HystrixProperty(name="execution.isolation.semaphore.maxConcurrentRequests", value="20")

},

fallbackMethod = "errMethod"

)

//线程池限流

@HystrixCommand(

commandProperties = {

@HystrixProperty(name = "execution.isolation.strategy", value = "THREAD")

},

threadPoolKey = "createOrderThreadPool",

threadPoolProperties = {

@HystrixProperty(name = "coreSize", value = "20"),

@HystrixProperty(name = "maxQueueSize", value = "100"),

@HystrixProperty(name = "maximumSize", value = "30"),

@HystrixProperty(name = "queueSizeRejectionThreshold", value = "120")

},

fallbackMethod = "errMethod"

)

-

快速失败机制

-

提供降级方案

//在被调用方的方法上放置

@HystrixCommand(fallbackMethod="耗时方法", commandProperties =

{

{@HystrixProperty(name="execution.isolation.thread.timeoutInMilliseconds", value="5000")}

})

//客户端配置

feign:

hystrix:

enabled: true

######################配置请求超时时间##########################

hystrix:

command:

default:

execution:

isolation:

thread:

timeoutInMilliseconds: 7000

####################配置具体方法超时时间 为 3 秒########################

DeptHystrixService#deptInfo_Timeout(Integer):

execution:

isolation:

thread:

timeoutInMilliseconds: 3000

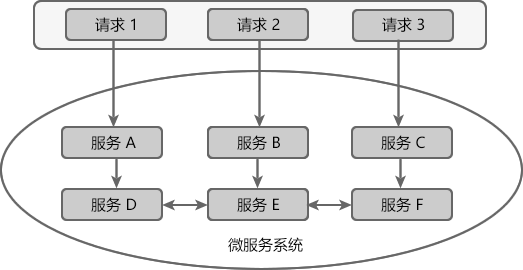

- 防止故障扩散

- 监控功能 负责服务的熔断与降级,考虑如下的服务调用:

引入依赖

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-hystrix</artifactId>

</dependency>

按开关

//二选一

//@EnableCircuitBreaker

@EnableHystrix

HystrixCommand

使用方法

在需要实现服务降级的方法上添加注解 @HystrixCommand . 然后配置 fallbackMethod 属性,其参数为发生异常时要降级到的方法的名称,此降级方法需要与 @HystrixCommand修饰的方法返回类型及参数保持一致。

HystrixCommand参数介绍

- fallbackMethod:指定服务降级处理方法;

- ignoreExceptions:忽略某些异常,不发生服务降级;

fallbackMethod (回调方法)

指定降级到的方法,此方法的返回类型及参数需要与@HystrixCommand修饰的方法返回类型及参数保持一致。

ignoreExceptions (忽略异常)

指定忽略掉某些异常,设置忽略这些异常后,在发生这些异常后不会进行降级处理。

@HystrixCommand(fallbackMethod = "fallback", ignoreExceptions = {NullPointerException.class})

public String getName(@PathVariable int id) {

System.out.println("====================");

if(1==1){

throw new NullPointerException();

}

return "房屋id="+id;

}

//降级方法,返回值及参数需要和上面被HystrixCommand修饰的方法保持一致,方法名就是上面fallbackMethod指定的方法名。

public String fallback(@PathVariable int id) {

return "降级方法id="+id;

}

超时配置

hystrix可以配置是否启用超时,以及超多多久时间视为超时。

hystrix:

command:

default:

execution:

isolation:

thread:

timeoutInMilliseconds: 500

timeout:

enabled: true

扩展--熔断状态

graph LR;

N[关闭状态]--有异常-->V{验证}

V--10S_and_50%-->S[启动状态]

S--所有请求直接进入-->F((fallback))

R{重试}--重试失败-->F

S --5秒后--> R

R---一旦请求成功则关闭熔断--->N

Feign简介

相比RestTemplate,Feign是更好更方便的远程访问工具。

一,基本使用

加依赖

<!-- eureka客户端 -->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>

<!-- Feign依赖 -->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-openfeign</artifactId>

</dependency>

按开关

在入口类上添加注解:

@EnableFeignClients

添加配置

如果没有添加eureka配置的需要添加此配置:

eureka:

instance:

prefer-ip-address: true

ip-address: 127.0.0.1

client:

register-with-eureka: true

fetch-registry: true

service-url:

defaultZone: http://localhost:8761/eureka/

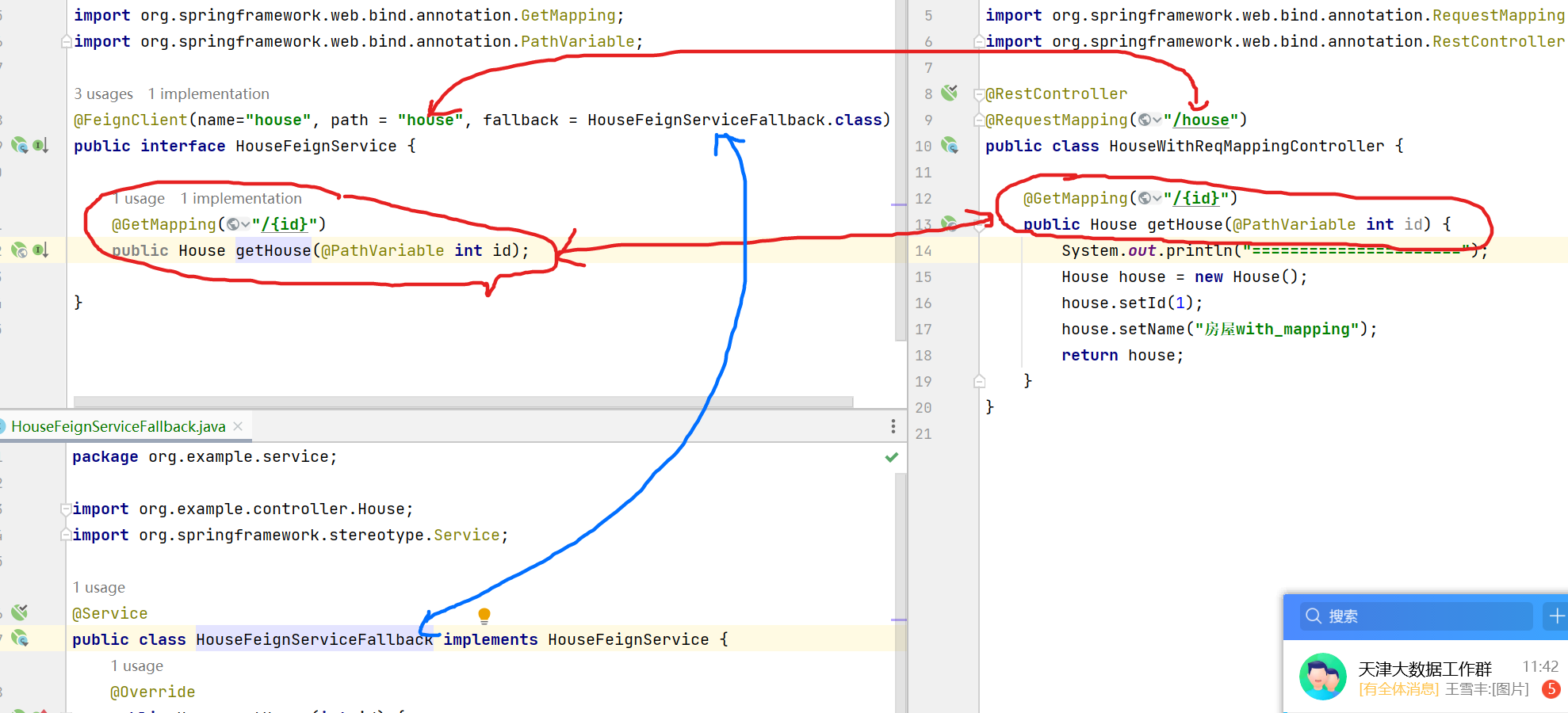

代码

//调用方接口定义

//这里的name="house"表示被调用方的服务名称

@FeignClient(name="house", path = "house", fallback = HouseFeignServiceFallback.class)

public interface HouseFeignService {

@GetMapping("/{id}")

public House getHouse(@PathVariable int id);

}

//被调用方代码

@RestController

@RequestMapping("/house")

public class HouseWithReqMappingController {

@GetMapping("/{id}")

public House getHouse(@PathVariable int id) {

System.out.println("======================");

House house = new House();

house.setId(1);

house.setName("房屋with_mapping");

return house;

}

}

两者之间的对应关系如下图中红色标识:

二,负载均衡

负载均衡使用ribbon来实现,所以修改负载均衡和上一节ribbon的修改方法一样。

//注意,需要放在被@Configuration修饰的类中

@Bean

public IRule myRule() {

return new RandomRule();

}

三,Feign的服务降级

Feign也支持服务降级,本质上它就是使用上节课学习的Hystrix来实现的。

修改Feign接口

添加降级类,降级类会在发生异常时接管处理。

@FeignClient(name="house", fallback = HouseFeignServiceFallback.class)

新建降级fallback类

降级类要实现上面定义的接口,并实现降级方法,另外注意在降级类上添加@Service注解,以纳入spring管理

@Service

public class OrderServiceCallback implements OrderServiceFeign{

@Override

public Integer getOrderNumberOfUser(Long id) {

return 22;

}

@Override

public Map postOrderNumberOfUser(Long id) {

Map result = new HashMap();

result.put("number",23);

return result;

}

}

改配置

因为feign也是使用hystrix实现的降级,且默认没有打开降级支持,所以这里需要打开hystrix功能:

feign:

hystrix:

enabled: true

四,打开日志

打开Feign调用日志,方便查找问题。

//注意,需要放在被@Configuration修饰的类中

@Bean

Logger.Level feignLogLevel() {

return Logger.Level.FULL;

}

同时,需要配置yml文件中的日志等级。

logging:

level:

org.example.service: debug

五,常用配置

压缩

客户端

feign:

hystrix:

enabled: true

compression:

response:

enabled: true

request:

enabled: true

min-request-size: 2048 # 超过2M则进行压缩

超时配置

在Feign配置超时时,真正的超时降级受两个地方的配置约束:

feign:

client:

config:

default:

read-timeout: 10000 # feign配置的读超时配置

hystrix:

enabled: true

hystrix:

command:

default:

execution:

isolation:

thread:

timeoutInMilliseconds: 30000 #hystrix配置的超时配置

gateway 简介

如果没有gateway,网页需要分别访问 house contract服务。 各服务还需要分别实现安全,流量控制。

一,基础使用

网关的作用-》 路由; 安全; 流量控制

1.添加依赖

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-gateway</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>

2.路由配置

2.1 通过配置文件配置路由

spring:

application:

name: gateway-server

cloud:

gateway:

routes:

- id: user

# uri: http://localhost:8083 #直接指定服务器地址,不推荐

uri: lb://user # 指定服务器注册实例名

filters: #在请求被转向后端服务之前可以进行更改。

- StripPrefix=1 # 去掉前缀过滤器

predicates: #断言,只有满足断言的请求才会被放过去。

- Path=/services/** # 如果访问路径以services开头,则执行本路由规则

eureka: # 顶格:另外记得入口类添加@EnableEurekaClient

instance:

ip-address: 127.0.0.1

prefer-ip-address: true

client:

fetch-registry: true

register-with-eureka: true

service-url:

defaultZone: http://localhost:8761/eureka/

2.2 通过代码配置路由

一般不使用,了解就好。

@Configuration

public class GatewayConfig {

@Bean

public RouteLocator customRouteLocator(RouteLocatorBuilder builder) {

StripPrefixGatewayFilterFactory factory = new StripPrefixGatewayFilterFactory();

StripPrefixGatewayFilterFactory.Config config = new StripPrefixGatewayFilterFactory.Config();

config.setParts(1);

GatewayFilter stripFilter = factory.apply(config);

return builder.routes()

.route("user", r-> r.path("/services/**")

.filters(gatewayFilterSpec -> gatewayFilterSpec.filter(stripFilter))

.uri("lb://user"))

.build();

}

}

2.3 概念解析:

路由中涉及到两个重要的新概念,断言和过滤器。

断言

断言就是判断,用来决定某个请求是不是应该由当前配置中的服务器来处理。我们最常用的就是Path断言,它是根据请求路径进行判断的。

过滤器

过滤器是对将要交给后端服务的请求进行进一步处理的地方。常用的是StripPrefix,一般和Path断言配合使用,用来将为了路由请求添加的路径去掉。

2.4 负载均衡

可以使用ribbon对路由进行负载均衡算法的自定义:

message:

ribbon:

NFLoadBalancerRuleClassName: com.netflix.loadbalancer.RandomRule

3. 实例讲解

假设我们有house服务,有如下配置和代码:

server:

port: 8081

spring:

application:

name: house

以上配置确定house服务的访问端口是8081。 以下代码决定了访问路径为 /house/list

@RestController

@RequestMapping("/house")

public class HouseController {

@GetMapping("/list")

public Result<IPage<House>> list(@RequestParam Integer page, @RequestParam(required = false) Integer size) {

int _size = size != null ? size : defaultSize;

IPage<House> ipage = new Page<>(page, _size);

houseService.page(ipage);

return Result.ok(ipage);

}

综合以上信息我们可以得出,通过house服务自己的端口访问list的url应该为:

http://localhost:8091/house/list?page=1&size=10

如果要通过网关访问,则再假设我们的gateway网关路由配置如下:

server:

port: 8080

spring:

application:

name: gateway

cloud:

gateway:

routes:

- id: house

# uri: http://localhost:8083 #直接指定服务器地址,不推荐

uri: lb://house # 指定服务器注册实例名

filters: #对请求进行进一步处理

- StripPrefix=1 # 去掉前缀过滤器

predicates: #断言

- Path=/order/** # 如果访问路径以services开头,则执行本路由规则

则最终通过网关的访问路径为

http://localhsot:8080/house/house/list?page=1&size=10

当这样一个请求到达网关时具体的处理流程是怎样的呢?

- 首先经过断言判断,因为请求路径 /house/house/list?page=1&size=10 满足 正则表达式 */house/** *,所以该请求将会被转到house服务处理

- 过滤器StripPrefix=1,表示要将请求路径的前1级路径去掉,则经过处理后请求路径变为 /house/list?page=1&size=10

- 因为已经没有别的过滤器,所以请求被转到house服务

- house服务刚好有处理 house/list?page=1&size=10 请求的方法,则访问成功被处理。

二,Route Predicate 一些常见断言

- Path Route Predicate

- Path=/user/{id} # curl http://localhost:8080/services/another/1 - Method Route Predicate

访问方法断言

- Method=GET # curl http://localhost:8080/services/another/1 - Header Route Predicate

请求头路由

- Header=X-Request-Id,\d+ # curl http://localhost:8080/services/another/1 -H X-Request-Id:88 - Cookie Route Predicate

Cookie路由断言

- Cookie=sessionId,test # curl http://localhost:8080/services/another/1 --cookie sessionId=test - Query Route Predicate

请求参数路由

- Query=name,pu. # http://localhost:8080/services/another/5?name=pu1 参数以name命名,值以pu开始共三位 - RemoteAddr Route Predicate 远端地址路由断言

- RemoteAddr=192.168.1.1/24

- Host Route Predicate 主机地址路由

- Host=**.baidu.com #

- Before Route Predicate

- Before=2022-10-24T16:30:00+08:00[Asia/Shanghai]

- After Route Predicate

- After=2019-09-24T16:30:00+08:00[Asia/Shanghai]

- Between Route Predicate

- Between=2019-09-24T16:30:00+08:00[Asia/Shanghai],2023-09-24T16:30:00+08:00[Asia/Shanghai]

三,Filter

部分过滤器

- AddRequestParameter

cloud:

gateway:

routes:

- id: user

uri: lb://user

filters:

- StripPrefix=1

- AddRequestParameter=username,bw00

- StripPrefix

cloud:

gateway:

routes:

- id: user

uri: lb://user

filters:

- StripPrefix=1

- PrefixPath

cloud:

gateway:

routes:

- id: user

uri: lb://user

filters:

- StripPrefix=1

- PrefixPath=/another

predicates:

- Path=/services/**

- Hystrix 除了之前Hystrix在单独的微服务中使用以外,Hystrix还可以在网关中使用。先添加依赖:

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-hystrix</artifactId>

</dependency>

编写降级处理代码:

@RestController

@RequestMapping

public class IndexController {

@GetMapping("/badthinghappend")

public ResponseEntity fallback4Another() {

return ResponseEntity.ok("badthinghappend ");

}

}

然后通过配置确定当异常发生时将请求降级到上面的路径来处理:

filters:

- StripPrefix=1

- name: Hystrix

args:

name: fallbackcmd

fallbackUri: forward:/badthinghappend

- RequestRateLimiter 请求速率限制是一个重要的技能点,需要重点学习下。因为速率限制需要redis记录一些数据,所以需要先添加依赖:

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis-reactive</artifactId>

</dependency>

然后还得添加redis配置:

spring:

redis:

host: localhost

port: 6379

最后在配置中添加过相关配置

filters:

- name: RequestRateLimiter

args:

redis-rate-limiter.replenishRate: 1 # 放令牌的速率

redis-rate-limiter.burstCapacity: 2 # 令牌桶最大放多少个

redis-rate-limiter.requestedTokens: 20 #每次请求消耗几个令牌(3.0以上支持)

key-resolver: "#{@ipKeyResolver}" # 根据userName来限流

上面的ipKeyResolver会引用项目中定义的实例,该实例需要在项目中定义,如下::

@Configuration

public class RedisRateLimiterConfig {

@Bean

KeyResolver ipKeyResolver() {

return new KeyResolver(){

@Override

public Mono<String> resolve(ServerWebExchange exchange) {

return Mono.just(exchange.getRequest().getRemoteAddress().getHostString());

}

};

}

}

四,全局过滤器(Global Filters)

添加global Filter定义

@Slf4j

@Component

public class LogGlobalFilter implements GlobalFilter, Ordered {

@Override

public int getOrder() {

return 10;

}

@Override

public Mono<Void> filter(ServerWebExchange exchange, GatewayFilterChain chain) {

String path = exchange.getRequest().getPath().value();

log.info("有人访问了: " + path);

return chain.filter(exchange);

}

}

在网关判断用户是否登录:

@Component

public class JWTFilter implements GlobalFilter, Ordered {

@Override

public Mono<Void> filter(ServerWebExchange exchange, GatewayFilterChain chain) {

String currentUrl = exchange.getRequest().getPath().value();

if(!"/user/user/login".equals(currentUrl)) {//登录url不要求用户已经登录

MultiValueMap<String, HttpCookie> cookies = exchange.getRequest().getCookies();

if(cookies != null && cookies.getFirst("token") != null) {

HttpCookie token = cookies.getFirst("token"); //获取jwt数据

String jwt = token.getValue();

boolean verify = JWTUtil.verify(jwt, "1234".getBytes()); //校验jwt是否合法

if(!verify) {

return needLogin(exchange);

}

}else {

return needLogin(exchange);

}

}

return chain.filter(exchange);

}

private Mono<Void> needLogin(ServerWebExchange exchange) {

exchange.getResponse().setStatusCode(HttpStatus.UNAUTHORIZED);

return exchange.getResponse().setComplete();

}

@Override

public int getOrder() {

return 0;

}

}

五,CORS 配置

注意!!!,在网关添加了跨域后,后面微服务自己添加的跨域需要去掉,否则会出错。

spring:

cloud:

gateway:

globalcors:

cors-configurations:

'[/**]':

allowedOrigins: "*"

allowedHeaders: "*"

allowedMethods: "*"

allowCredentials: true

maxAge: 360000

六,常见错误

- 在gateway的pom文件或父pom文件中引入web依赖:

<!--gateway中不能引入!-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

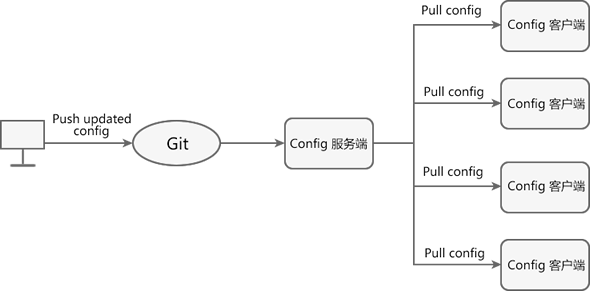

一,Spring Cloud Config

示意图

git仓库

示例: config-repo 各位同学要创建自己的repo。

创建步骤简要描述:

- 创建仓库

- 创建文件夹

- 在文件夹中创建 user-dev.yml文件

- 回到仓库首页,点击管理

- 在管理页面下方找到开源选项并选中

- 提交后即可访问

二,Config服务端配置

新建config项目

添加依赖

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-config-server</artifactId>

</dependency>

入口类加注解

@EnableConfigServer

配置文件添加

spring:

cloud:

config:

server:

git: #配置存储信息的Git仓库

#username: xxx

#password: 123456

uri: https://gitee.com/nixf/config-repo.git # 仓库地址

clone-on-start: true # 启动时直接从gitee获取数据

search-paths: unit_5 # 搜索目录

default-label: master # 默认的分支

label: master #分支信息

测试

测试config服务器配置是否生效,以如下所示格式访问

http://localhost:8888/application_name/profile/branch_name

application_name: 指应用的注册名 profile: 环境(dev,test,product) branch_name: git分支名

以我们创建git仓库时建的文件user-dev.yml为例,对它的内容访问路径为:

http:localhost:8888/user/dev/master

可以在user-dev.yml中添加内容后再查看效果。

三,客户端配置

添加依赖

<!--此jar包会读取bootstrap.yml,给应用使用config服务的机会 -->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-bootstrap</artifactId>

<version>3.1.1</version>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-config-client</artifactId>

</dependency>

新建bootstrap.yml

server:

port: 9092 #修改为你安排的端口

spring:

application:

name: message # 修改为你应用的注册名

cloud:

config:

profile: dev # 指定开发环境,还可以是test product等。

label: master # git分支

uri: http://localhost:8888 #config 服务地址

name: user #当前应用名,用于匹配git内的配置文件

演示对git中配置文件定义的属性的访问。

//(6-1)

@RestController

@RefreshScope

public class ConfigController {

//读取配置中的值,此值只在git内有

@Value("${my-name}")

private String myName;

@GetMapping("/my-name")

public String getConfigName() {

return myName;

}

}

刷新

刷新需要使用actuator的refresh端口。 http://localhost:8888/actuator/refresh

添加actuator依赖

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

同时打开refresh端口

management:

endpoints:

web:

exposure:

include: 'refresh'

也可以打开全部端口:

management:

endpoints:

web:

exposure:

include: '*'

@RefreshScope

注意上面例子(6-1)的@RefreshScope注解,它对于使用自定义变量在通过接口通知后自动刷新本地变量至关重要。

四,config 高可用

配置config高可用后,就不能再指定一个url路径了,需要使用eureka的帮助自动匹配服务地址。

cloud:

config:

profile: dev

lable: master

# uri: http://localhost:8888

name: user

discovery: # 启用自动寻址

enabled: true # 打开为TRUE

service-id: config # config的服务ID--即eureka的注册名

eureka:

instance:

prefer-ip-address: true

ip-address: 127.0.0.1

# instance-id: user

client:

register-with-eureka: true # 注册到eureka

fetch_registry: true #从服务器获取注册信息

service-url:

defaultZone: http://localhost:8761/eureka/ # 注册中心地址

五,Spring Cloud Bus

Spring Cloud Bus需要使用RabbitMQ帮助。 参见 Rabbit安装

RabbitMQ的相关概念

- Broker 消息队列服务

- Connection publisher 和 consumer 与broker的tcp连接

- Channel 逻辑连接

- Exchange 分发消息 p2p topic multicast/fanout

- Queue 真正的消息队列

- Binding exchange和queue之间的虚拟连接

MQ通用概念:

graph LR Publisher --发送消息--> Broker Broker --推消息--> Receiver Receiver --拉消息--> Broker

Config服务和Config客户端接入Spring Cloud Bus后,我们可以只通知Config服务更新配置,即可实现所有的客户端都自动更新配置的目的。 步骤如下:

config server配置

服务端需要接入rammbitMQ,所以增加以下依赖:

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-bus-amqp</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

同时,配置文件中添加rabbitMQ的配置。同时打开bus-refresh端口,通过此端口通知Config服务刷新配置。

spring:

rabbitmq:

host: localhost

port: 5672

username: guest

password: guest

management:

endpoints:

web:

exposure:

include: 'bus-refresh' # config服务端开发端口,通过post访问

config client配置

Config 客户端也需要接入RabbitMQ。添加依赖:

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-bus-amqp</artifactId>

</dependency>

添加配置文件:

spring:

rabbitmq:

host: localhost

port: 5672

username: guest

password: guest

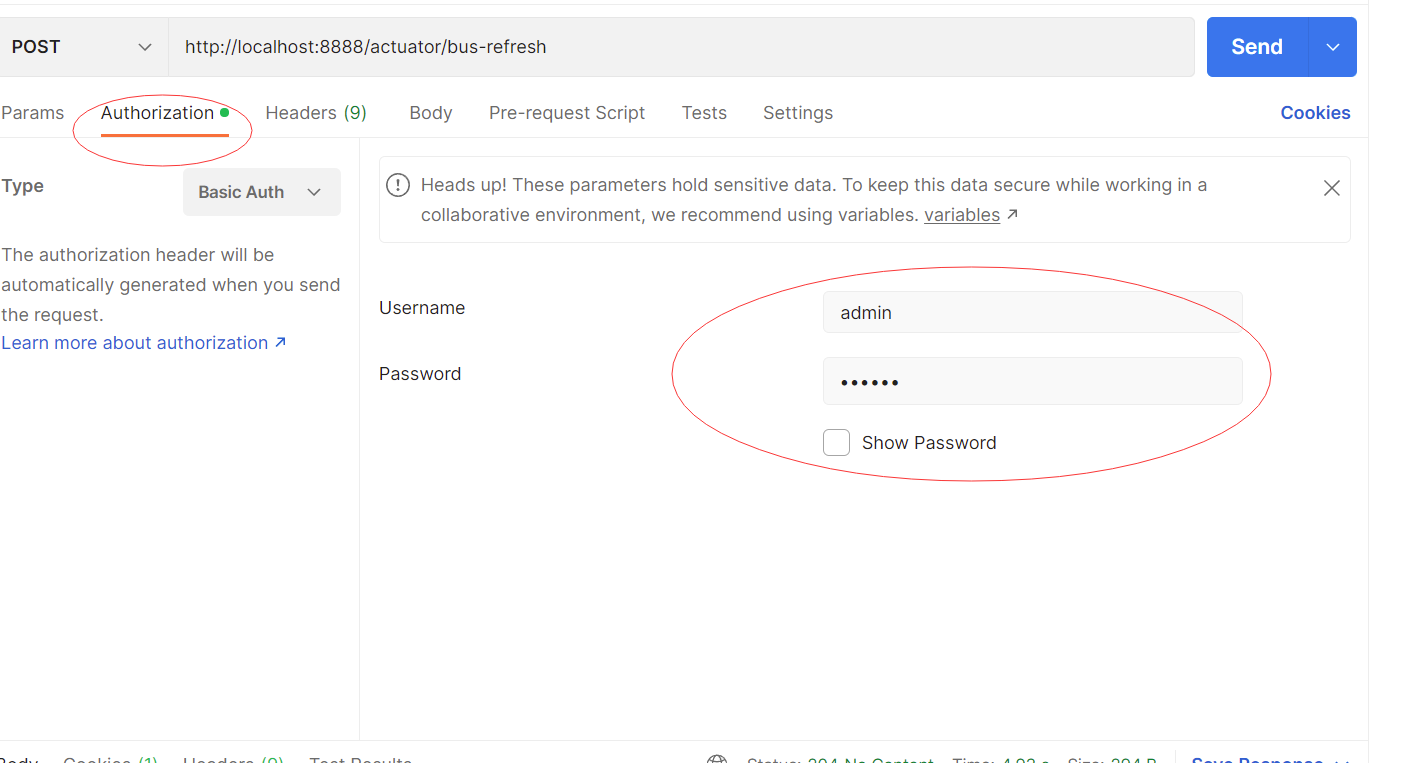

测试

更改git的配置后,使用Post方法调用 http://localhost:8888/actuator/bus-refresh 即可更新所有通过bus链接到config服务的配置。

六,Config服务器安全

引进安全jar包:

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-security</artifactId>

</dependency>

设置服务的用户名和密码:

spring:

application:

name: config

security:

user:

name: admin

password: 123456

放开刷新接口的访问:

@Configuration

public class SecurityConfig extends WebSecurityConfigurerAdapter {

protected void configure(HttpSecurity http) throws Exception {

http.authorizeRequests().anyRequest()

.authenticated()

.and().httpBasic().and().csrf().disable();

}

}

客户端添加安全配置:

cloud:

config: # house-dev.yml

profile: dev # 指定开发环境,还可以是test product等。

label: master # git分支

# uri: http://localhost:8888 #config 服务地址

name: house #当前应用名,用于匹配git内的配置文件

discovery: # 启用自动寻址

enabled: true # 打开为TRUE

service-id: config # config的服务ID--即eureka的注册名

username: admin

password: 123456

使用Postman刷新:

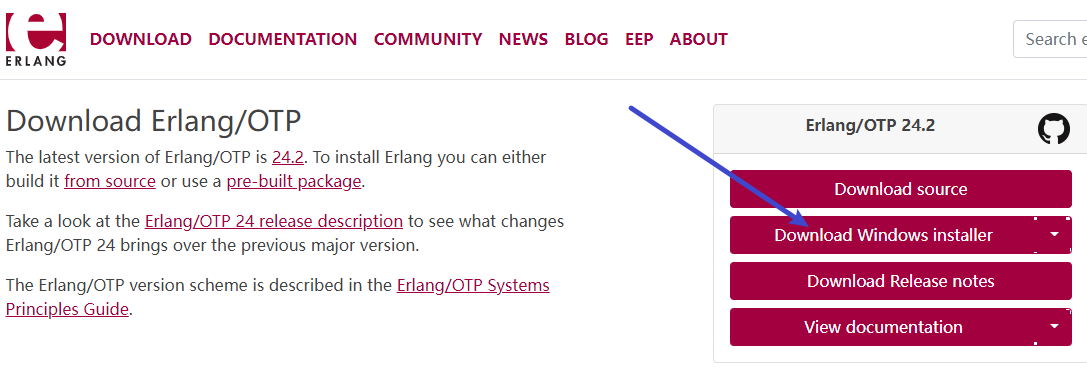

Rabbit 安装

rabbitMQ 是基于Erlang语言开发的,因此在安装rabbit之前需要先安装erlang。 安装时需要注意几点:

1,文件路径不要有中文、空格;

2,计算机名不要有中文

Erlang 安装

官网:https://www.erlang.org/downloads

下载地址: http://erlang.org/download/otp_win32_21.3.exe

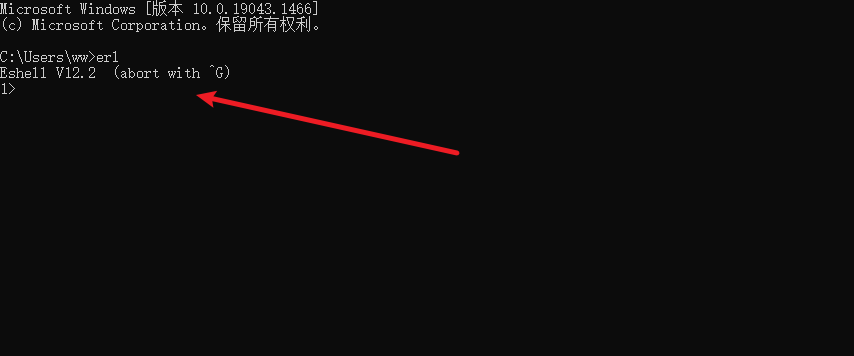

配置Erlang环境变量

新建系统变量:

ERLANG_HOME

C:\Program Files\erl-24.2

将bin追加到Path变量中

%ERLANG_HOME%\bin

测试Erlang环境

erl

下载RabbitMQ

rabbitMQ下载: https://github.com/rabbitmq/rabbitmq-server/releases/tag/v3.7.14

rabbitMQ下载: https://github.com/rabbitmq/rabbitmq-server/releases/tag/v3.7.14

安装管理插件:

在rabbit的sbin目录下执行:

rabbitmq-plugins enable rabbitmq_management

安装完成后访问: http://localhost:15672/

用户名和密码: guest/guest

用户名和密码: guest/guest

问题解决

再次确认安装路径中没有空格,中文字符。 再次确认当前用户名不是中文。 确认后进行以下操作。

- 以上操作都按照步骤执行了,还是不能访问。 打开系统服务,找到RabbitMQ,重新启动。

- 还是不行。 执行

rabbitmq-plugins list

查看rabbitmq_management 确实安装了。如果确实安装了 在执行 rabbitmq-service stop rabbitmq-service start

Sleuth 简介

请求追踪,问题(性能,异常)定位

一, 给服务添加链路追踪

加依赖

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-zipkin</artifactId>

</dependency>

添加配置

spring:

zipkin: # 指定zipkin服务器地址

base-url: http://localhost:9411

sleuth:

sampler: # 采样器

probability: 0.1 # 设置Sleuth抽样收集的概率

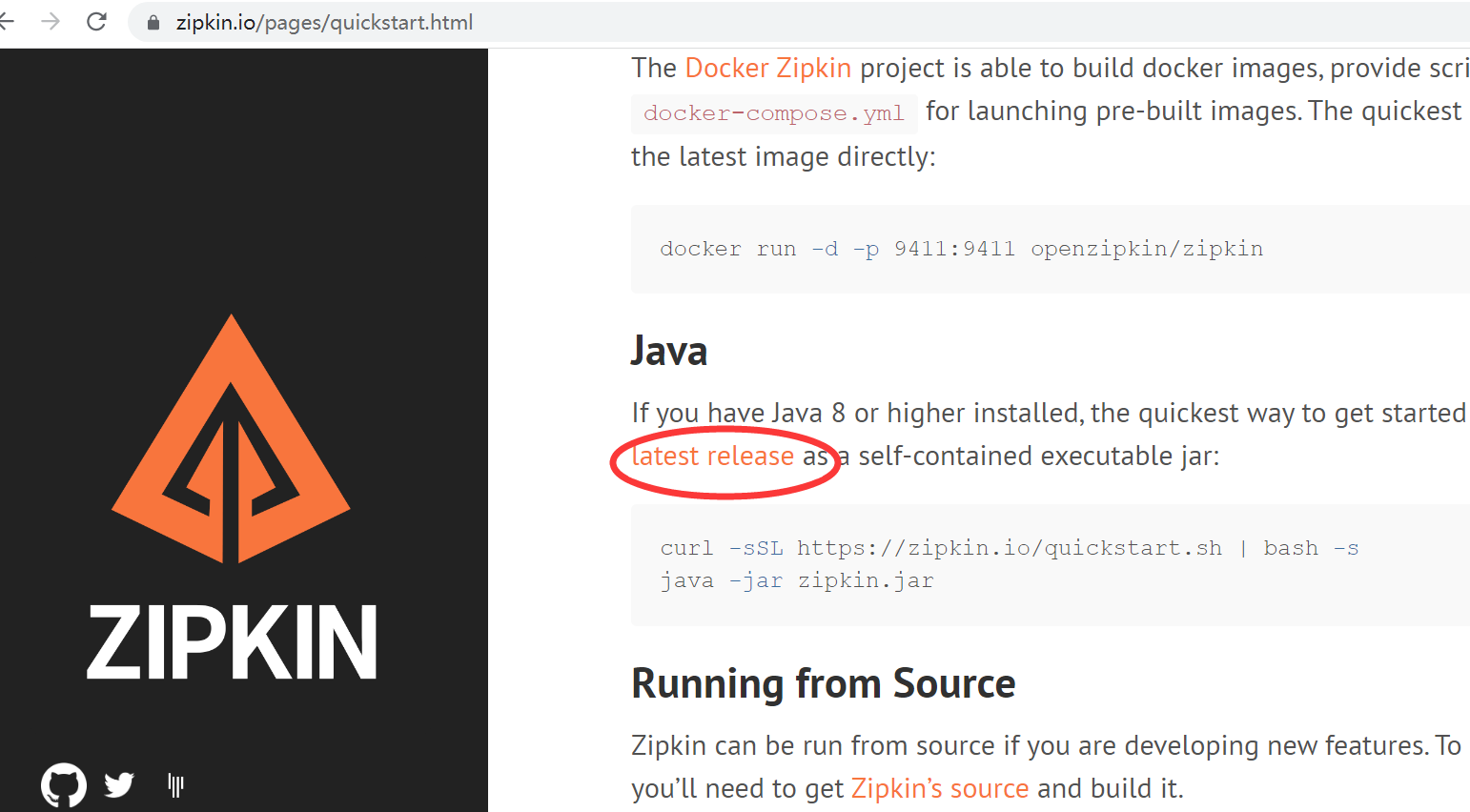

安装zipkin

主页地址: https://zipkin.io/

下载后使用如下命令启动zipkin:

下载后使用如下命令启动zipkin:

java -jar zipkin-server-2.23.19-exec.jar

zipkin概念

- span-跨度-范围

- trace-追踪-痕迹

使用ES持久化存储跟踪信息

- 安装ES

- ES Header chrome 安装 /Volumes/workspace/es-head/es-head

- zipkin启动时传入使用ES的参数

# STORAGE_TYPE:表示存储类型 ES_HOSTS:表示ES的访问地址

java -jar zipkin-server-2.12.9-exec.jar --STORAGE_TYPE=elasticsearch --ES_HOSTS=localhost:9200

Spring Boot Admin

Spring Boot Admin 通过 Actuator 获得应用运行过程中的各项指标。以图形化界面展示出来。监控以下内容:

- 应用概览信息

- 度量指标信息

- 环境变量信息

- 所有创建的Bean信息

- 查看应用中所有配置信息

- 应用运行日志信息

- 查看JVM信息

- 查看可以访问的Web端点

- 查看HTTP跟踪信息

一 admin-server

新建admin项目,按照以下步骤添加依赖和配置。

1.添加依赖

<dependency>

<groupId>de.codecentric</groupId>

<artifactId>spring-boot-admin-starter-server</artifactId>

<version>2.2.4</version>

</dependency>

2.打开开关

@EnableAdminServer

3.配置

server:

port: 9301

spring:

application:

name: admin-server

访问http://localhost:9301查看效果

二 admin-client

选择(或新建)项目,作为admin client接入admin服务。

1. 引依赖

<!--admin客户端-->

<dependency>

<groupId>de.codecentric</groupId>

<artifactId>spring-boot-admin-starter-client</artifactId>

<version>2.2.4</version> <!--2.6.2不兼容 -->

</dependency>

<!-- 开启监控接口-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

2. 配置

spring.boot.admin.client.url 告诉admin server地址 management 开启查询端口

spring:

boot:

admin:

client:

url: http://localhost:9301 #配置admin-server地址

management:

endpoints:

web:

exposure:

include: '*'

endpoint:

health:

show-details: always

logging:

file: # 开启admin的日志监控

name: admin-client.log

启动后,再次查看admin服务,可以观察到接入服务的相关信息。

三 演示

- 1 访问监控地址 http://localhost:9301

- 2 点击wallboard按钮,选择要监控的实例查看详情

- 3 度量指标信息 JVM,Tomcat及进程信息

- 4 环境变量信息

- 5 所有的Bean信息

- 6 查看应用中的所有配置信息

- 7 查看日志信息

四 结合注册中心

上面的配置中我们指定了admin服务的地址,这样admin服务地址变更时就比较麻烦,所以我们可以使用eureka来实现动态查找admin服务。

Admin Server的修改

首先需要引入eureka client依赖和添加相应配置。

添加eureka-client

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

</dependency>

打开EurekaClient

@EnableEurekaClient

添加注册中心配置

eureka:

client:

fetch-registry: true #指定是否要从注册中心获取服务(注册中心不需要开启)

register-with-eureka: true #指定是否要注册到注册中心(注册中心不需要开启)

# 需要注意,如果eureka服务开始了security保护,这里需要有用户名和密码

# http://username:password@localhost:8761/eureka/

#集群的配置

#defaultZone: http://node1:8761/eureka,http://node2:8762/eureka,http://node3:8763/eureka

#单机的配置

service-url:

defaultZone: http://localhost:8761/eureka/

Admin Client

management: # Admin 通过 actuator提供的端口进行监控系统,因此需要打开各端口

endpoints:

web:

exposure:

include: '*'

endpoint:

health:

show-details: always

logging:

file: # 开启admin的日志监控

name: admin-client.log

五 添加登陆认证

引入安全依赖

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-security</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

配置用户名和密码

spring:

security:

user:

name: xxx

password: 123456

boot:

admin:

discovery:

ignored-services: ${spring.application.name} # 忽略自己的信息

增加security后,对于没有使用eureka注册中心,直接去通知admin的就 会受到影响,需要对security进行配置,以允许admin-client对admin的请求。

Spring Security

@Configuration

public class SecuritySecureConfig extends WebSecurityConfigurerAdapter {

private final String adminContextPath;

public SecuritySecureConfig(AdminServerProperties adminServerProperties) {

this.adminContextPath = adminServerProperties.getContextPath();

}

@Override

protected void configure(HttpSecurity http) throws Exception {

SavedRequestAwareAuthenticationSuccessHandler successHandler = new SavedRequestAwareAuthenticationSuccessHandler();

successHandler.setTargetUrlParameter("redirectTo");

successHandler.setDefaultTargetUrl(adminContextPath + "/");

http.authorizeRequests()

//1.配置所有静态资源和登录页可以公开访问

.antMatchers(adminContextPath + "/assets/**").permitAll()

.antMatchers(adminContextPath + "/login").permitAll()

.antMatchers(adminContextPath+"/instances").permitAll()

.antMatchers(adminContextPath+"/actuator/**").permitAll()

.anyRequest().authenticated()

.and()

//2.配置登录和登出路径

.formLogin().loginPage(adminContextPath + "/login").successHandler(successHandler).and()

.logout().logoutUrl(adminContextPath + "/logout").and()

//3.开启 http basic 支持,admin-client 注册时需要使用

.httpBasic().and()

.csrf()

//4.开启基于 cookie 的 csrf 保护

.csrfTokenRepository(CookieCsrfTokenRepository.withHttpOnlyFalse())

//5.忽略这些路径的 csrf 保护以便 admin-client 注册

.ignoringAntMatchers(adminContextPath + "/instances",adminContextPath + "/actuator/**");

}

}

合同录入

环境复杂度

- [合同编号重复]

Snowflake snowflake = IdUtil.getSnowflake();

String id = "HT"+snowlake.nextId();

- [身份证号码格式不正确]

/^\d{6}(18|19|20)?\d{2}(0[1-9]|1[012])(0[1-9]|[12]\d|3[01])\d{3}(\d|[xX])$/

- 租客身份证和租客姓名不真实 api服务入口

@PostMapping("/verify")

public Result<Boolean> verify(@RequestBody Contract contract) {

Map<String,Object> map = new HashMap<>();

map.put("idNo", contract.getIdNo());

map.put("name", contract.getName());

String body = HttpRequest.post("https://idenauthen.market.alicloudapi.com/idenAuthentication")

.header("Authorization", "APPCODE b30006ab97e44f33b9398fd90094e676")

.form(map)

.execute()

.body();

System.out.println(body);

int index = body.indexOf("身份证信息匹配");

return Result.ok(index>0);

}

- [计算合同金额精度缺失]

- 主要涉及BigDecimal的计算。

BigDecimal first = BigDecimal.valueOf(10.22);

BigDecimal second = BigDecimal.valueOf(8);

BigDecimal sum = first.add(second);

BigDecimal subtract = first.subtract(second);

BigDecimal subtract2 = second.subtract(first);

BigDecimal multiply = first.multiply(second);

BigDecimal divide = first.divide(second);

boolean bigger = first.compareTo(second) > 0;

boolean equal = first.compareTo(BigDecimal.valueOf(10.220)) == 0;

boolean less = second.compareTo(first) < 0;

- [reddssion 分布式锁]

引入依赖:

<dependency>

<groupId>org.redisson</groupId>

<artifactId>redisson-spring-boot-starter</artifactId>

<version>3.15.5</version>

</dependency>

添加配置:

spring:

redis:

redisson:

singleServerConfig:

password: 123456

address: "/redis:127.0.0.1:6379"

使用代码:

@GetMapping("/lock/test")

public boolean lock(int id) {

RLock lock = redissonClient.getLock("test-lock-reddison" + id);

try {

lock.lock(1, TimeUnit.SECONDS);

Thread.sleep(10000);

return true;

}catch (InterruptedException e) {

}finally {

lock.unlock();

}

return false;

}

收房合同录入功能

- 合同信息录入

- 合同录入选择房产

- 附件处理

- 付款单生成

表设计

合同信息录入

合同录入下:

- [房间租赁合同和客户身份证上传失败] 大文件时涉及断点上传

- [网络请求被篡改]

服务端验证请求、计算金额

[应收房款分期计算有误差]

使用BigDecimal [租房合同保存失败,数据不完整] 事务

文件上传 MinIO

安装

参考视频 安装MiniO

启动命令:

minio.exe server D:\tmp\minio

其中 D:\tmp\minio 是图片存储根目录。需要根据自己的情况设置。

添加依赖

<dependency>

<groupId>io.minio</groupId>

<artifactId>minio</artifactId>

<version>7.0.2</version>

</dependency>

上传示例代码

private final String BUCKET_NAME = "2010a";

@PostMapping("/upload")

public Result<String> upload(MultipartFile file) throws InvalidPortException, InvalidEndpointException, IOException, InvalidBucketNameException, InsufficientDataException, ErrorResponseException, NoSuchAlgorithmException, InvalidKeyException, InvalidResponseException, XmlParserException, InternalException {

//改写名字,但是不能改写类型;

String name = file.getOriginalFilename(); // a.jpg;

name = name.substring(name.indexOf(".")); //.jpg

name = IdUtil.getSnowflakeNextIdStr()+name;// 随机数 + .jpg

//修改为自己服务器上的key和secret。

MinioClient minioClient = new MinioClient("http://localhost:9000", "ExgAQimtkr6sKLWW", "OyWuId4T1SqzMjJpZ9u8AQX2YL0Rm8Nq");

PutObjectOptions options = new PutObjectOptions(file.getSize(), 11111111);

options.setContentType(file.getContentType());

minioClient.putObject(BUCKET_NAME, name, file.getInputStream(), options);

String url = "http://localhost:9000/"+BUCKET_NAME+"/"+name;

return Result.ok(url);

}

配置servlet支持大文件

spring:

servlet:

multipart:

enabled: true

max-file-size: 500MB

max-request-size: 2048MB

环境介绍

沙箱环境

在我们的学习,考试中主要使用这个环境的信息,包含appId,支付网关地址,签名等信息。 沙箱环境

文档中心

https://opendocs.alipay.com/open/028r8t?ref=api&scene=22

调试中心

调试中心包含各api的调用例子,使我们开发学习的主要参考: https://open.alipay.com/dev/workspace/apidebug

代码示例

jsp示例,这里包含有文档中心及调试中心都不存在的支付回调验签代码。 支付回调验签

管理平台

正式的开发需要创建应用,并使用它的appId等信息,但是现在不是必须使用它。 创建应用

内网穿透工具

支付宝支付成功后有个回调地址,因为支付宝只能访问外网地址,所以我们或者自己部署到云服务器,或者使用内网穿透工具提供外网地址。 如下是两个(类)常用的穿透工具。

花生壳

需要去线上认证下:

ngrok

版本众多,可用的不多。

开发

依赖

首先需要引进依赖的jar包。

<dependency>

<groupId>com.alipay.sdk</groupId>

<artifactId>alipay-sdk-java</artifactId>

<version>4.33.50.ALL</version>

</dependency>

配置

使用从沙箱环境获得的信息配置AliClient。

@Configuration

public class AlipayConfiguration {

@Bean

public static AlipayClient alipayClient() {

AlipayConfig config = new AlipayConfig();

//支付宝测试环境服务器

config.setServerUrl("https://openapi.alipaydev.com/gateway.do");

//支付宝应用id,在沙箱环境内获取

config.setAppId("2016092100560986");

//引用私钥,建议使用《支付宝开放平台开发助手》生成,RSA2

config.setPrivateKey("MIIEvAIBADANBgkqhkiG9w0BAQEFAASCBKYwggSiAgEAAoIBAQCLq2XQiqUVyxyO+vT3VIXOhIGWvL1SIs9p28kurzgXzV8JR0X2h+TrSjfyjwYRQH9aV5FFy9NIciA1ce0ZPfxniDt4Bs0pHqLJfkRaUhkotVWn8F6kqqoypy1NfLseDx8GsGXnWVST0wV7xpeOlQM6cflVwYTxx5topyZc5u6NbLssdb/DX1ABjsMsinJQpbgutJFYwy+iWIM7MTSOds4FwZpWdowZ824zfqCMyWibiP1JmguXVcl14eWyOv6LDvDe0niXiF2qMDrTUReVVb+XwEsGb1/cdJT9wU0JDreRH1SSwE6Z+sQdQClfqB/WQJZniveugGf4bXnnZRQfo44fAgMBAAECggEAH7dCHYL+Td6bk5RFQEy/PdA1JSeizh39f4pbOvCrCiymohK/PmZJg2yNG9WCiTReNwOfh3vrdI4F5l0CfDLpOBFlf7H7sJS2Xo7/sormD6pt0v7wXvAqSepQjUH/s6m3X+t6mHhejlri6eKE0+nem8z505FoQQcUsUUTnxEJpq9s1f8SxVF0+6v2va2UqyCbPwKIR0bQLLF7K8a2jl2YBaHRntRi7BCqt4z+IQmHkI6M1zDOysSVbeVX3XlAc54nseorSHAY3ywmjkFSPmBc5MDzNSFgSG2IdHzlTU7R2F4wvExbFGPh64UODzlwcyZFYaTVwUdxhS8JxyXsnHTsQQKBgQDjJs/CMee4AWTN9GNj3XfVW29xjta7XGFJh5BaQRuABpI10nfNyadfwHC7PxjauGqHX2TTpc6991m+kaHOdX5nUyjMOAkhIrmJT1xgPHEjr15Enzp5f8L9NgpMdOJlUne3Uf9cA8pww/lQlEHHcdvoofEYSHoAxMT7wwSut8VdcQKBgQCdaFrfmHtN4AOovtauy3AbdfhhkoyCzN6g/sTDyI4CbLIbMIfqlXTG/RaJYCLVevnmSGCryflDQT69JicSNOVseRZEHli3Qr3G1sS2zU495ZlQGFe6DZomCkw3RxJcX5z25rvvcW3ECDRGpEG17SvMxXWwpD2+0WQL87wEnuwcjwKBgGyak96/SZC6ad3mqNaIftDtxJzAtH4kLwee3y+nzWQqwCEnncwwS+wF8GA2TMXWQmiy/VwL/IrrBmeM7ZXuqx7vraPmbsb++UJjRUFl5JoxMJsSnjyVDz9NZSMlB1F2WnK1q6fs0A+WQ095cvHOyFuzgbggfuR7L8tHdKesiZqhAoGAR4OU3cc6JhxjrTPe95Un/uHvEe1x9y866mw1WznwAvv9Q0seRR7X6lwr9AgAa3sutEgn24SswbiP14HQ+H2dylWNHy+mYMRq0j7bKq5GIOsCZ5hXqwjpAuVk0SxyFBPAjZAwzE19cDXGAl44GH6DisofeTx1bQ9W4/M9dd/6J9MCgYBzW54BbochobX23cFy6QTOQ1zEUGVaabC4rx8/2M9qbORjVWKIcNOLNErm/BmIXkwU/7dPGdkL98poIvYP172obCHdR/vWNEfA9SzTFO2Dkgr7zsJcMM0H/DrUWVx0PFJoQX6uPMnkF71jupqbg0uYtzkVfKVBQ2GA294fWHlvew==");

//json

config.setFormat("json");

//支付宝的公钥,不是咱自己的。沙箱应用处获取

config.setAlipayPublicKey("MIIBIjANBgkqhkiG9w0BAQEFAAOCAQ8AMIIBCgKCAQEAtovPlNX2W2/vY7e9FCyb7WTeR61VbgScDzDMpRo866u8ucubHgj9HTt4ebsvwsi5d20l1tqT77mEbEwjCqA8CtfeDyATYuHB+P7SWnotjIIXfFfIAgeAqyIl+7TlsBKt13XAVwQh2LqP2xpzqUCHlhJrvQrrWckzliL/SaqfkHbXRPHqN3O4vNORfOyu5FqXxO5oZ8ADebVkouzi6Rv/wMTazERXIwg2YXYjqkOOQzrojKuHUdHDL9vlC3b0ht1z7cUPLdQE86UoOZCj55dLUvjoZsyxKM/tsGjwvmKJGxvUnDDX88KbGexxFpUS8aN2t0OkE2yzGZgbDtAO3pDTuQIDAQAB");

//UTF-8

config.setCharset("UTF-8");

//RSA2

config.setSignType("RSA2");

try {

return new DefaultAlipayClient(config);

} catch (AlipayApiException e) {

throw new RuntimeException(e);

}

}

}

支付:

建议参考如下文档:

https://opendocs.alipay.com/open/028r8t?ref=api&scene=22

或者如下代码

@GetMapping("/pay/{id}")

public String pay(@PathVariable int id) throws AlipayApiException {

Pay pay = payService.getById(id);

AlipayTradePagePayRequest request = new AlipayTradePagePayRequest();

AlipayTradePagePayModel model = new AlipayTradePagePayModel();

model.setOutTradeNo(pay.getUuid());

model.setTotalAmount(pay.getTotal()+"");

model.setSubject("房租");

model.setProductCode("FAST_INSTANT_TRADE_PAY");//固定写死这个

request.setBizModel(model);

request.setReturnUrl("http://localhost:8081/order"); // 前端跳转地址

request.setNotifyUrl("https://6217to9865.goho.co/pay/cj/ali_callback"); //支付宝通过后端回调我们的地址。

AlipayTradePagePayResponse response = alipayClient.pageExecute(request);

return response.getBody();

}

打开支付页面

在前端页面打开支付页面时,需要在前端el-button的click事件处理中使用类似如下的代码打开

//order 是要支付的订单

pay(order) {

//以下为新开页面打开

window.open("http://localhost:8080/order/pay/pay/"+order.id);

//以下为原页面打开

//window.location.href="http://localhost:8080/order/pay/pay/"+order.id

}

后端支付回调(简化实现--内网穿透工具可用时)

@RequestMapping("/ali_callback")

public String callback(String out_trade_no) { //OutTradeNo --> out_trade_no

Pay pay = payService.getByUUID(out_trade_no);

pay.setStatus(PayStatus.PAID.name());

boolean success = payService.updateById(pay);

// 成功返回 succes 失败 返回 fail

return success ? "success" : "fail";

}

前端支付回调 (简化实现--内网穿透工具不可用时)

//本实现方式为简化实现方式,仅用于内网穿透不可用时,工作中不可这样使用。

@GetMapping("/callback")

public void callback(@RequestParam String out_trade_no, HttpServletResponse response) throws IOException {

QueryWrapper query = new QueryWrapper();

query.eq("uuid", out_trade_no); //根据传入的参数out_trade_no(数据库中的uuid字段)构建查询

Order order = orderService.getOne(query);

order.setStatus("PAID"); //更新支付单为已支付

orderService.updateById(order);

response.sendRedirect("http://localhost:8081/products"); //跳转页面到目的页面

}

支付回调(完整实现--实际工作时):

@RequestMapping("/ali_callback")

public Object aliCallback(HttpServletRequest request) {

Map<String,String> params = combineRequestParams(request);

try {

boolean verified = AlipaySignature.rsaCheckV2(params, aliProperties.getPublicKey(), "utf-8", aliProperties.getSignType());

if(!verified) {

return ServerResponse.badRequest().body("非法请求,验证不通过");

}

String status = params.get("trade_status");

if("TRADE_SUCCESS".equals(status)) {

String out_trade_no = params.get("out_trade_no");

Pay pay = payService.getByUUID(out_trade_no);

pay.setPayDate(new Date());

pay.setStatus(PayStatus.PAID.name());

payService.saveOrUpdate(pay);

return "success";

}

//确认支付状态是支付成功

//确认价格一致

//需要添加更新订单处理。

return "fail";

} catch (AlipayApiException e) {

log.info("支付宝回调异常", e);

return "fail";

}

}

private static Map<String, String> combineRequestParams(HttpServletRequest request) {

Map<String,String> params = new HashMap<>();

Map requestParams = request.getParameterMap();

for(Iterator it = requestParams.keySet().iterator(); it.hasNext();) {

String name = (String) it.next();

String[] values = (String[]) requestParams.get(name);

String valueStr = "";

for(int i=0; i<values.length; i++) {

valueStr = i==(values.length-1) ? valueStr+values[i] : valueStr+values[i]+",";

}

params.put(name, valueStr);

}

params.remove("sign_type");

return params;

}

支付宝支付(下)

扫单:

定时查询未支付单,进行处理:

- 已支付更新状态。

- 未支付视情况通知支付。

定时任务实现:

- 在入口类添加注解:

@EnableScheduling

- 在要执行的方法上添加

@Scheduled(cron = "0 * * * * ? ")

// 秒 分 时 日 月 周

- * 表示所有值。 例如:在分的字段上设置 *,表示每一分钟都会触发。

- ? 表示不指定值。使用的场景为不需要关心当前设置这个字段的值。例如:要在每 月的 10 号触发一个操作,但不关心是周几,所以需要周位置的那个字段设置为”?” 具体 设置为 0 0 0 10 * ?

- - 表示区间。例如 在小时上设置 “10-12”,表示 10,11,12 点都会触发。

- , 表示指定多个值,例如在周字段上设置 “MON,WED,FRI” 表示周一,周三和周五 触发

- / 用于递增触发。如在秒上面设置”5/15” 表示从 5 秒开始,每增 15 秒触发 (5,20,35,50)。 在日字段上设置’1/3’所示每月 1 号开始,每隔三天触发一次。

- L 表示最后的意思。在日字段设置上,表示当月的最后一天(依据当前月份,如果 是二月还会依据是否是润年[leap]), 在周字段上表示星期六,相当于”7”或”SAT”。如果在”L” 前加上数字,则表示该数据的最后一个。例如在周字段上设置”6L”这样的格式,则表示“本 月最后一个星期五”

- W 表示离指定日期的最近那个工作日(周一至周五). 例如在日字段上置”15W”,表示 离每月 15 号最近的那个工作日触发。如果 15 号正好是周六,则找最近的周五(14 号)触 发, 如果 15 号是周未,则找最近的下周一(16 号)触发.如果 15 号正好在工作日(周一至周 五),则就在该天触发。如果指定格式为 “1W”,它则表示每月 1 号往后最近的工作日触发。 如果 1 号正是周六,则将在 3 号下周一触发。(注,”W”前只能设置具体的数字,不允许区 间”-“)。

- # 序号(表示每月的第几个周几),例如在周字段上设置”6#3”表示在每月的第三个周 六.注意如果指定”#5”,正好第五周没有周六,则不会触发该配置(用在母亲节和父亲节再 合适不过了) ;小提示:’L’和 ‘W’可以一组合使用。如果在日字段上设置”LW”,则表示在 本月的最后一个工作日触发;周字段的设置,若使用英文字母是不区分大小写的,即 MON 与 mon 相同。

掉单:

@GetMapping("/query/{id}")

public Result<Boolean> query(@PathVariable int id) throws AlipayApiException, JsonProcessingException {

Pay pay = payService.getById(id);

AlipayTradeQueryRequest request = new AlipayTradeQueryRequest();

AlipayTradeQueryModel model = new AlipayTradeQueryModel();

model.setOutTradeNo(pay.getUuid());

request.setBizModel(model);

AlipayTradeQueryResponse response = alipayClient.execute(request);

System.out.println(response.getBody());

Map result = objectMapper.readValue(response.getBody(), Map.class);

result = (Map)result.get("alipay_trade_query_response");

if("TRADE_SUCCESS".equals(result.get("trade_status"))) {

if(PayStatus.PAID.name().equals(pay.getStatus())) {

//不做事情

return Result.ok(true);

}else {

pay.setStatus(PayStatus.PAID.name());

payService.updateById(pay);

return Result.ok(true);

}

}else {

return Result.ok(false);

}

//wqt

}

退款:

public boolean refund(int orderId, BigDecimal amount) throws AlipayApiException {

AlipayTradeRefundRequest request = new AlipayTradeRefundRequest();

AlipayTradeRefundModel model = new AlipayTradeRefundModel();

model.setOutTradeNo(String.valueOf(orderId));

model.setRefundAmount(amount.toPlainString());

request.setBizModel(model);

AlipayTradeRefundResponse response = alipayClient.execute(request);

return response.isSuccess();

}

退款查询:

public boolean checkRefund(int id) {

Pay pay = payService.getById(id);

AlipayTradeFastpayRefundQueryRequest request = new AlipayTradeFastpayRefundQueryRequest();

AlipayTradeFastpayRefundQueryModel model = new AlipayTradeFastpayRefundQueryModel();

model.setOutRequestNo(pay.getUuid());

request.setBizModel(model);

AlipayTradeFastpayRefundQueryResponse response = alipayClient.execute(request);

.....

}

下载支付单:

public String billDownload(String date) throws AlipayApiException {

AlipayDataDataserviceBillDownloadurlQueryRequest request = new AlipayDataDataserviceBillDownloadurlQueryRequest();

AlipayDataDataserviceBillDownloadurlQueryModel model = new AlipayDataDataserviceBillDownloadurlQueryModel();

model.setBillType("trade");

model.setBillDate(date);

request.setBizModel(model);

//String content = "{\"bill_type\":\"trade\" , \"bill_date\":\""+date+"\"}";

//System.out.println(content);

//request.setBizContent(content);

AlipayDataDataserviceBillDownloadurlQueryResponse response = alipayClient.execute(request);

System.out.println(response.getBody());

String url = response.getBillDownloadUrl();

return url;

}

功能汇总

定义工具类,完成支付所有功能。(不包含支付后回调)

public class PayUtils {

public static String pay(String out_trade_no, String price, String name, String returnUrl, String notifyUrl) throws AlipayApiException {

AlipayTradePagePayRequest request = new AlipayTradePagePayRequest();

AlipayTradePagePayModel model = new AlipayTradePagePayModel();

model.setOutTradeNo(out_trade_no);

model.setTotalAmount(price);

model.setSubject(name);

model.setProductCode("FAST_INSTANT_TRADE_PAY");

request.setBizModel(model);

request.setReturnUrl(returnUrl);

request.setNotifyUrl(notifyUrl);

AlipayTradePagePayResponse response = alipayClient().pageExecute(request);

return response.getBody();

}

public static boolean check(String out_trade_no) throws AlipayApiException {

AlipayTradeQueryRequest request = new AlipayTradeQueryRequest();

AlipayTradeQueryModel model = new AlipayTradeQueryModel();

model.setOutTradeNo(out_trade_no);

request.setBizModel(model);

AlipayTradeQueryResponse response = alipayClient().execute(request);

return response.isSuccess();

}

public static boolean refund(String out_trade_no, BigDecimal amount) throws AlipayApiException {

AlipayTradeRefundRequest request = new AlipayTradeRefundRequest();

AlipayTradeRefundModel model = new AlipayTradeRefundModel();

model.setOutTradeNo(out_trade_no);

model.setRefundAmount(amount.toPlainString());

request.setBizModel(model);

AlipayTradeRefundResponse response = alipayClient().execute(request);

return response.isSuccess();

}

public static String checkRefund(String out_trade_no) throws AlipayApiException {

AlipayTradeFastpayRefundQueryRequest request = new AlipayTradeFastpayRefundQueryRequest();

AlipayTradeFastpayRefundQueryModel model = new AlipayTradeFastpayRefundQueryModel();

model.setOutRequestNo(out_trade_no);

request.setBizModel(model);

AlipayTradeFastpayRefundQueryResponse response = alipayClient().execute(request);

return response.getBody();

}

public static String billDownload(String date) throws AlipayApiException {

AlipayDataDataserviceBillDownloadurlQueryRequest request = new AlipayDataDataserviceBillDownloadurlQueryRequest();

AlipayDataDataserviceBillDownloadurlQueryModel model = new AlipayDataDataserviceBillDownloadurlQueryModel();

model.setBillType("trade");

model.setBillDate(date);

request.setBizModel(model);

//String content = "{\"bill_type\":\"trade\" , \"bill_date\":\""+date+"\"}";

//System.out.println(content);

//request.setBizContent(content);

AlipayDataDataserviceBillDownloadurlQueryResponse response = alipayClient().execute(request);

System.out.println(response.getBody());

String url = response.getBillDownloadUrl();

return url;

}

public static AlipayClient alipayClient() {

AlipayConfig config = new AlipayConfig();

//支付宝测试环境服务器

config.setServerUrl("https://openapi.alipaydev.com/gateway.do");

//支付宝应用id,在沙箱环境内获取

config.setAppId("2016092100560986");

//引用私钥,建议使用《支付宝开放平台开发助手》生成,RSA2

config.setPrivateKey("MIIEvAIBADANBgkqhkiG9w0BAQEFAASCBKYwggSiAgEAAoIBAQCLq2XQiqUVyxyO+vT3VIXOhIGWvL1SIs9p28kurzgXzV8JR0X2h+TrSjfyjwYRQH9aV5FFy9NIciA1ce0ZPfxniDt4Bs0pHqLJfkRaUhkotVWn8F6kqqoypy1NfLseDx8GsGXnWVST0wV7xpeOlQM6cflVwYTxx5topyZc5u6NbLssdb/DX1ABjsMsinJQpbgutJFYwy+iWIM7MTSOds4FwZpWdowZ824zfqCMyWibiP1JmguXVcl14eWyOv6LDvDe0niXiF2qMDrTUReVVb+XwEsGb1/cdJT9wU0JDreRH1SSwE6Z+sQdQClfqB/WQJZniveugGf4bXnnZRQfo44fAgMBAAECggEAH7dCHYL+Td6bk5RFQEy/PdA1JSeizh39f4pbOvCrCiymohK/PmZJg2yNG9WCiTReNwOfh3vrdI4F5l0CfDLpOBFlf7H7sJS2Xo7/sormD6pt0v7wXvAqSepQjUH/s6m3X+t6mHhejlri6eKE0+nem8z505FoQQcUsUUTnxEJpq9s1f8SxVF0+6v2va2UqyCbPwKIR0bQLLF7K8a2jl2YBaHRntRi7BCqt4z+IQmHkI6M1zDOysSVbeVX3XlAc54nseorSHAY3ywmjkFSPmBc5MDzNSFgSG2IdHzlTU7R2F4wvExbFGPh64UODzlwcyZFYaTVwUdxhS8JxyXsnHTsQQKBgQDjJs/CMee4AWTN9GNj3XfVW29xjta7XGFJh5BaQRuABpI10nfNyadfwHC7PxjauGqHX2TTpc6991m+kaHOdX5nUyjMOAkhIrmJT1xgPHEjr15Enzp5f8L9NgpMdOJlUne3Uf9cA8pww/lQlEHHcdvoofEYSHoAxMT7wwSut8VdcQKBgQCdaFrfmHtN4AOovtauy3AbdfhhkoyCzN6g/sTDyI4CbLIbMIfqlXTG/RaJYCLVevnmSGCryflDQT69JicSNOVseRZEHli3Qr3G1sS2zU495ZlQGFe6DZomCkw3RxJcX5z25rvvcW3ECDRGpEG17SvMxXWwpD2+0WQL87wEnuwcjwKBgGyak96/SZC6ad3mqNaIftDtxJzAtH4kLwee3y+nzWQqwCEnncwwS+wF8GA2TMXWQmiy/VwL/IrrBmeM7ZXuqx7vraPmbsb++UJjRUFl5JoxMJsSnjyVDz9NZSMlB1F2WnK1q6fs0A+WQ095cvHOyFuzgbggfuR7L8tHdKesiZqhAoGAR4OU3cc6JhxjrTPe95Un/uHvEe1x9y866mw1WznwAvv9Q0seRR7X6lwr9AgAa3sutEgn24SswbiP14HQ+H2dylWNHy+mYMRq0j7bKq5GIOsCZ5hXqwjpAuVk0SxyFBPAjZAwzE19cDXGAl44GH6DisofeTx1bQ9W4/M9dd/6J9MCgYBzW54BbochobX23cFy6QTOQ1zEUGVaabC4rx8/2M9qbORjVWKIcNOLNErm/BmIXkwU/7dPGdkL98poIvYP172obCHdR/vWNEfA9SzTFO2Dkgr7zsJcMM0H/DrUWVx0PFJoQX6uPMnkF71jupqbg0uYtzkVfKVBQ2GA294fWHlvew==");

//json

config.setFormat("json");

//支付宝的公钥,不是咱自己的。沙箱应用处获取

config.setAlipayPublicKey("MIIBIjANBgkqhkiG9w0BAQEFAAOCAQ8AMIIBCgKCAQEAtovPlNX2W2/vY7e9FCyb7WTeR61VbgScDzDMpRo866u8ucubHgj9HTt4ebsvwsi5d20l1tqT77mEbEwjCqA8CtfeDyATYuHB+P7SWnotjIIXfFfIAgeAqyIl+7TlsBKt13XAVwQh2LqP2xpzqUCHlhJrvQrrWckzliL/SaqfkHbXRPHqN3O4vNORfOyu5FqXxO5oZ8ADebVkouzi6Rv/wMTazERXIwg2YXYjqkOOQzrojKuHUdHDL9vlC3b0ht1z7cUPLdQE86UoOZCj55dLUvjoZsyxKM/tsGjwvmKJGxvUnDDX88KbGexxFpUS8aN2t0OkE2yzGZgbDtAO3pDTuQIDAQAB");

//UTF-8

config.setCharset("UTF-8");

//RSA2

config.setSignType("RSA2");

try {

return new DefaultAlipayClient(config);

} catch (AlipayApiException e) {

throw new RuntimeException(e);

}

}

}

看房

-

预约看房业务流程

-

预约看房表结构设计

-

预约看房前后端交互实现

-

短信发送

-

环境复杂度

-

短信通知实现

榛子云

//注册

http://sms_developer.zhenzikj.com/zhenzisms_user/register.html

//登录

http://sms_developer.zhenzikj.com/zhenzisms_user/login.html

//SDK

http://smsow.zhenzikj.com/doc/java_sdk_doc.html

依赖

<dependency>

<groupId>com.zhenzikj</groupId>

<artifactId>zhenzisms</artifactId>

<version>2.0.2</version>

</dependency>

配置

# 榛子云短信

zzy:

url: https://sms_developer.zhenzikj.com

appId: 112605

secret: 6a987156-398b-4c3c-9d84-ce6b3921bd18

代码示例

简单的发送短信:

@GetMapping("/send_sms")

public Boolean sendSMS(String phone) throws Exception {

ZhenziSmsClient client = new ZhenziSmsClient("https://sms_developer.zhenzikj.com", "112605", "6a987156-398b-4c3c-9d84-ce6b3921bd18");

Map<String, Object> params = new HashMap<String, Object>();

params.put("number", phone);

params.put("templateId", "10759");

String[] templateParams = new String[2];

templateParams[0] = "3421";

templateParams[1] = "5";

params.put("templateParams", templateParams);

String result = client.send(params);

System.out.println("sms.result = " + result);

JSON json = JSONUtil.parse(result);

Integer code = (Integer) json.getByPath("code");

return code==0;

}

短信发送失败如何处理

-

找到错误的原因 一般可以根据api调用的返回判断,一般发生错误的原因: 格式出错 违禁词汇 区域受限 技术层面出错 达到限额 余额不足

-

出现错误怎么解决:

自己找不到原因时要寻找客服人员的帮助 为预防错误,多使用短信模板或固定模板。

短信接口异常如何处理

可以针对特定异常或异常吗进行重试 记录日志,后期和运营商沟通.

发送短信失败重试,如果三次后仍不成功则打印日志代码示例:

@GetMapping("/send_sms_retry")

public Result<Boolean> sendSms(String phone) throws Exception {

Boolean success = retrySend(phone,4);

return Result.ok(success);

}

private Boolean retrySend(String phone, int num) {

if(num <=0 ){

log.error("发送短信失败,重试后仍旧失败!" + phone);

return false;

}

ZhenziSmsClient client = new ZhenziSmsClient("https://sms_developer.zhenzikj.com", "112605", "6a987156-398b-4c3c-9d84-ce6b3921bd18");

Map<String, Object> params = new HashMap<String, Object>();

params.put("number", phone);

params.put("templateId", "10759");

String[] templateParams = new String[2];

templateParams[0] = "3421";

templateParams[1] = "5";

params.put("templateParams", templateParams);

String result = null;

try {

result = client.send(params);

} catch (Exception e) {

this.retrySend(phone, num-1);

}

System.out.println("sms.result = " + result);

JSON json = JSONUtil.parse(result);

Integer code = (Integer) json.getByPath("code");

if(code != 0){

this.retrySend(phone, num-1);

}

return code==0;

}

RocketMQ 基础

作用

解耦 异步 削峰

问题

系统可用性降低

如何保证MQ的高可用

系统复杂度提高

怎么保证消息没有被重复消费? 消费者保证。 防止消息丢失?

生产者 -- 使用事务消息

消费者 -- 使用消息确认

broker -- 早写盘,多备份

安装

下载地址:

https://rocketmq.apache.org/download

版本选择 4.9.3

windows版本方法:

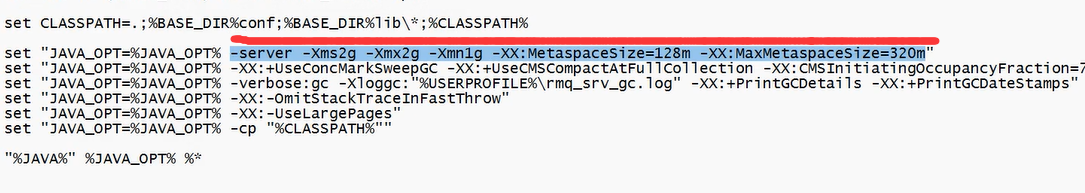

修改启动脚本

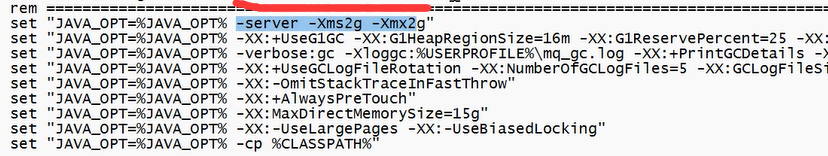

因为RocketMQ的名称服务器和broker占用内存较大,所以需要将内存调低些。具体是将下面划红线部分替换为:

-server -Xms256m -Xmx256m -Xmn128m

- 修改 runserver.cmd

- 修改 runbroker.cmd

设置环境变量:

在系统环境变量中新增

ROCKETMQ_HOME

指向 RocketMQ的安装目录(bin的上一层目录)

启动

启动名称服务器,先跳转到bin目录

mqnamesrv

启动broker服务器:

mqbroker -n localhost:9876

启动时需要指定名称服务器地址,这个是通过-n来指定的。

测试

测试是为了确保服务器功能正常,测试方法如下:

在命令窗口中先运行 set NAMESRV_ADDR=localhost:9876 以设置环境变量, 然后运行生产者

tools.cmd org.apache.rocketmq.example.quickstart.Producer

和消费者

tools.cmd org.apache.rocketmq.example.quickstart.Consumer

看到N多发送消息和接收消息即是正常。

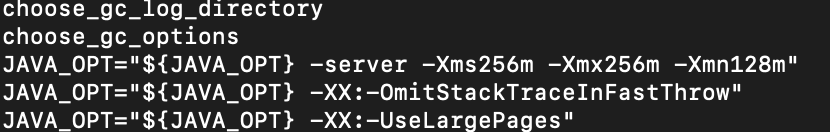

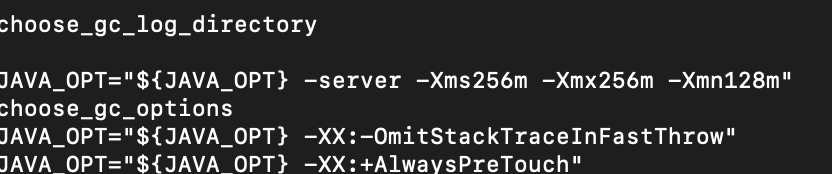

linux版本方法:

修改启动脚本

将namesrv和broker的内存占用修改为: -server -Xms256m -Xmx256m -Xmn128m

-

修改nameServer的启动脚本 找到choose_gc_options后,在下面一行做如下修改 vi ./bin/runserver.sh

-

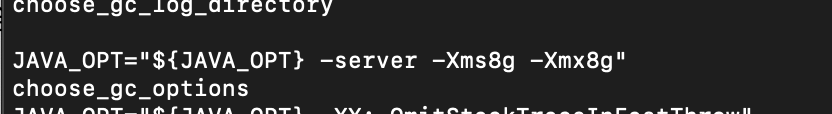

修改broker的启动脚本 找到如下图

修改为前面所述的内存大小:

修改为前面所述的内存大小:

vi ./bin/runbroker.sh

启动

启动名称服务器

nohup sh bin/mqnamesrv &

启动broker服务

nohup sh bin/mqbroker -n localhost:9876 &

测试

export NAMESRV_ADDR=localhost:9876

./bin/tools.sh org.apache.rocketmq.example.quickstart.Producer

./bin/tools.sh org.apache.rocketmq.example.quickstart.Consumer s

开发

应用引入jar包:

<dependency>

<groupId>org.apache.rocketmq</groupId>

<artifactId>rocketmq-spring-boot-starter</artifactId>

<version>2.1.0</version>

</dependency>

配置rocketMQ相关信息

rocketmq:

name-server: 127.0.0.1:9876 # rocketMQ 名称服务器

producer:

group: test # 发送组

topic: test-topic # topic 相当于一个地址

retry-times-when-send-failed: 5 # 错了以后重试几次

consumer:

group: test-consumer #消费者组

topic: test-topic # 消费topic

消息的发送

同步发送

@PostMapping("/send")

public Map<String,String> send(@RequestParam String msg) {

Message<String> message = MessageBuilder.withPayload(msg).build();

SendResult result = rocketMQTemplate.syncSend(topic,message);

if(SendStatus.SEND_OK.equals(result.getSendStatus())) {

return this.of("status", "ok");

}else {

return this.of("status", "error");

}

}

异步发送

public void asyncSend(String msg) {

Message<String> message = MessageBuilder.withPayload(msg).build();

rocketMQTemplate.asyncSend(topic, message, new SendCallback() {

@Override

public void onSuccess(SendResult sendResult) {

SendStatus sendStatus = sendResult.getSendStatus();

if(SendStatus.SEND_OK.equals(sendStatus)) {

System.out.println("异步发送消息成功");

}else {

System.out.println("异步发送没有成功。"+sendStatus.name());

}

}

@Override

public void onException(Throwable throwable) {

System.out.println("异步发送消息时发生了错误");

}

});

}

延迟发送

// 1s 5s 10s 30s 1m 2m 3m 4m 5m 6m 7m 8m 9m 10m 20m 30m 1h 2h

@PostMapping("/delay_send")

public Map<String,String> send(@RequestParam String msg) {

Message<String> message = MessageBuilder.withPayload(msg).build();

SendResult result = rocketMQTemplate.syncSend(topic,message,500,5);

if(SendStatus.SEND_OK.equals(result.getSendStatus())) {

return this.of("status", "ok");

}else {

return this.of("status", "error");

}

}

消息的接收

@Service

@RocketMQMessageListener(nameServer = "${rocketmq.name-server}", topic="${rocketmq.producer.topic}", consumerGroup = "${rocketmq.consumer.group}")

public class MQListener implements RocketMQListener<String> {

@Override

public void onMessage(String rocketMqMessage) {

System.out.println("=====I have got a message. = " + rocketMqMessage);

}

}

确保消息不丢失

0.失败重试

rocketmq:

name-server: 127.0.0.1:9876 # rocketMQ 名称服务器

producer:

group: test # 发送组

topic: test-topic # topic 相当于一个地址

retry-times-when-send-failed: 5 # 错了以后重试几次

consumer:

group: test-consumer #消费者组

topic: test-topic # 消费topic

1.发送事务消息

public void sendTransactional(String msg) {

Message message = MessageBuilder.withPayload(msg).build();

TransactionSendResult sendResult = rocketMQTemplate.sendMessageInTransaction(topic, message, transactionalListener);

}

@Component

@RocketMQTransactionListener

public class TransactionalListener implements RocketMQLocalTransactionListener {

int times = 0;

@Autowired

UserService userService;

@Override

public RocketMQLocalTransactionState executeLocalTransaction(Message message, Object o) {

try{

userService.deleteUser(6);

return RocketMQLocalTransactionState.COMMIT;

}catch (Exception e) {

return RocketMQLocalTransactionState.ROLLBACK;

}

// return RocketMQLocalTransactionState.UNKNOWN;

}

@Override

public RocketMQLocalTransactionState checkLocalTransaction(Message message) {

times ++;

System.out.println("=====第"+times+"次重试。");

if(times > 5) {

System.out.println("重试5次后终于成功");

return RocketMQLocalTransactionState.COMMIT;

}

return RocketMQLocalTransactionState.UNKNOWN;

}

}

2. 确认接收

@Component

public class AcknowledgeListener implements MessageListenerOrderly {

@Value("${rocketmq.name-server}")

private String nameServer;

@Value("${rocketmq.producer.topic}")

private String topic;

@Value("${rocketmq.consumer.group}")

private String group;

private DefaultMQPushConsumer consumer;

@PostConstruct

public void init() throws MQClientException {

consumer =new DefaultMQPushConsumer();

consumer.setNamesrvAddr(this.nameServer); //设置RocketMQ NameSrv 地址

consumer.subscribe(topic,"*"); // 订阅指定topic的内容

consumer.setConsumerGroup(group); //设置消费者组

consumer.setInstanceName("another"); //设置实例名,确保不重复

consumer.registerMessageListener(this); //注册消息监听者,这里注册自己为监听者

consumer.start();

}

@Override

public ConsumeOrderlyStatus consumeMessage(List<MessageExt> list, ConsumeOrderlyContext consumeOrderlyContext) {

if(CollectionUtils.isEmpty(list)){

return ConsumeOrderlyStatus.SUCCESS;

}

for(MessageExt ext : list) {

String msg = new String(ext.getBody());

processMessage(msg);

}

return ConsumeOrderlyStatus.SUCCESS;

}

private void processMessage(String msg) {

System.out.println("receive "+msg);

}

}

启动不起来

- CLASS_PATH 设置不正确。

服务端配置

- 集群配置

- 主从写同步

- 磁盘写同步

RocketMQ 集群

集群部署:

我们要创建一个2主2从的RocketMQ集群,同时NameServer也创建两个。

windows版本

创建store根路径

D:\workspaces\rocketmq-4.9.3\data\a

D:\workspaces\rocketmq-4.9.3\data\as

D:\workspaces\rocketmq-4.9.3\data\b

D:\workspaces\rocketmq-4.9.3\data\bs

修改broker配置文件

# 集群名称

brokerClusterName=DefaultCluster

# broker名称,Master和Slaver要保持统一

brokerName=broker-a

# 0 表示主; 1表示从

brokerId=0

deleteWhen=04

fileReservedTime=48

brokerRole=SYNC_MASTER

flushDiskType=ASYNC_FLUSH

# 创建topic时缺省创建队列数

defaultTopicQueueNums=4

# 自动创建话题,线上关闭

autoCreateTopicEnable=true

autoCreateSubscriptionGroup=true

# IP1 为主用

brokerIP1=127.0.0.1

# IP2 是从找主用

brokerIP2=127.0.0.1

# 端口号,各实例间端口号差距多些更好

listenPort=10931

# 存储主地址

storePathRootDir=D:/workspaces/rocketmq-4.9.3/data/a

# 名称服务器地址

namesrvAddr=127.0.0.1:9876;127.0.0.1:9870

新建namesrv配置文件 namesrv-1.properties

listenPort=9870

和 namesrv-2.properties。

listenPort=9876

启动集群:

start bin\mqnamesrv.cmd -c conf\2m-2s-sync\namesrv-1.properties

start bin\mqnamesrv.cmd -c conf\2m-2s-sync\namesrv-2.properties

start bin\mqbroker.cmd -c conf\2m-2s-sync\broker-a.properties

start bin\mqbroker.cmd -c conf\2m-2s-sync\broker-a-s.properties

start bin\mqbroker.cmd -c conf\2m-2s-sync\broker-b.properties

start bin\mqbroker.cmd -c conf\2m-2s-sync\broker-b-s.properties

linux版本:

创建store根路径

/home/nixinfeng/workspace/rocketmq-4.9.3/data/am

/home/nixinfeng/workspace/rocketmq-4.9.3/data/as

/home/nixinfeng/workspace/rocketmq-4.9.3/data/bm

/home/nixinfeng/workspace/rocketmq-4.9.3/data/bs

创建配置文件:

brokerClusterName=DefaultCluster

brokerName=broker-a

brokerId=0

deleteWhen=04

fileReservedTime=48

brokerRole=SYNC_MASTER

flushDiskType=ASYNC_FLUSH

listenPort=10911

storePathRootDir=/home/nixinfeng/workspace/rocketmq-4.9.3/data/am

namesrvAddr=127.0.0.1:9876

启动集群:(需要补上namesrv的启动)

nohup bin/mqbroker -c /home/nixinfeng/workspace/rocketmq-4.9.3/conf/2m-2s-sync/broker-a.properties &

nohup bin/mqbroker -c /home/nixinfeng/workspace/rocketmq-4.9.3/conf/2m-2s-sync/broker-a-s.properties &

nohup bin/mqbroker -c /home/nixinfeng/workspace/rocketmq-4.9.3/conf/2m-2s-sync/broker-b.properties &

nohup bin/mqbroker -c /home/nixinfeng/workspace/rocketmq-4.9.3/conf/2m-2s-sync/broker-b-s.properties &

可能遇到的问题汇总

- 无报错直接退出

- 配置文件路径问题,windows和linux不同。

- 存储数据的路径权限不够

- 端口分配,貌似rocket会占用临近的端口号

xxl-job

下载:

https://gitee.com/xuxueli0323/xxl-job/tags

选择一个双数版本,例如:2.2.0版本。

- 初始化数据库 执行脚本

/xxl-job/doc/db/tables_xxl_job.sql

- 修改配置文件

进入到xxl-job-admin项目中,修改配置文件application.properties(在文件夹xxl-job-admin\src\main\resources下)中的端口号, 数据库用户名及密码也改成本地的用户名和密码; - 编译运行xxl-job-admin

在xxl-job-admin目录中运行下面的命令:

mvn spring-boot:run

- 登录xxl-job-admin 地址 http://localhost:9999/xxl-job-admin/ 的缺省密码

admin/123456

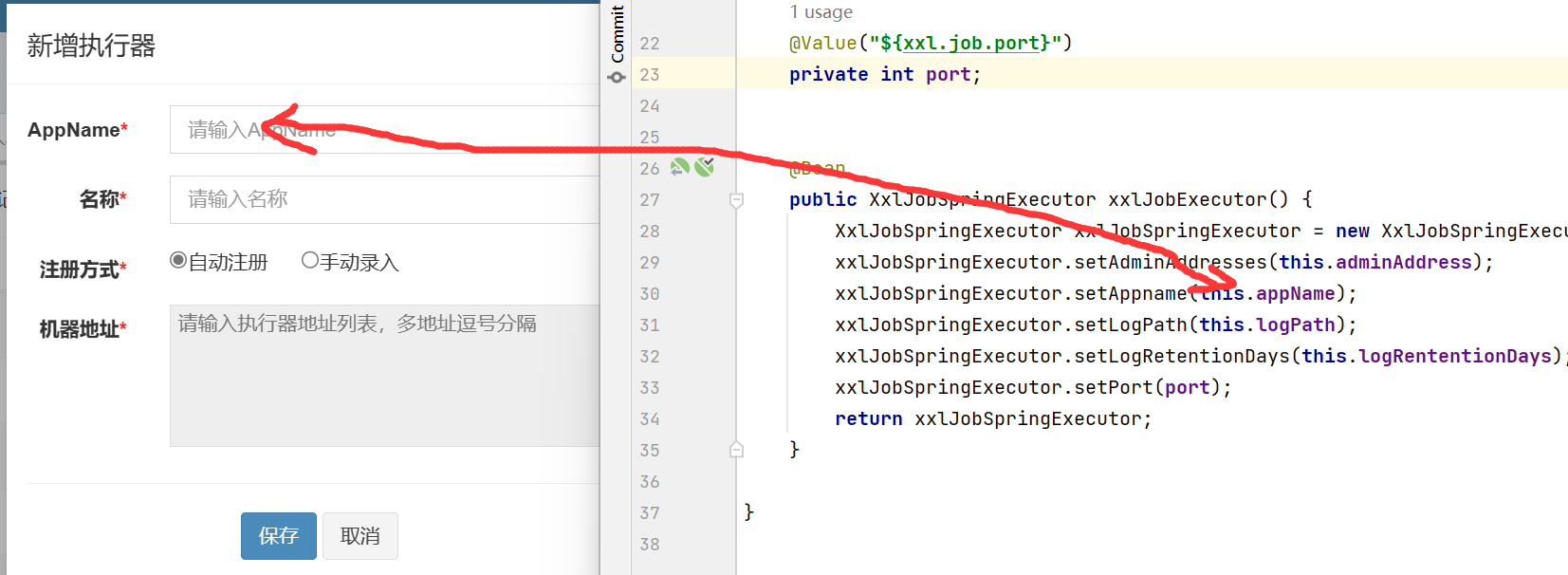

介绍:

主要涉及到两个概念

执行器

执行器用来执行任务的对象XxlJobSpringExecutor,XxlJobSpringExecutor定义在我们自己的项目中,它的名称用来在xxl-job-admin中标识某个项目。

设置执行器

设置任务

设置任务

任务

任务是真正执行逻辑的地方,它的运营受到xxl-job-admin的指挥。

在项目中使用

引入依赖

<dependency>

<groupId>com.xuxueli</groupId>

<artifactId>xxl-job-core</artifactId>

<version>2.2.0</version>

</dependency>

添加配置

xxl:

job:

port: 9998 # xxl-job服务本地监听端口,如果有多个需要使用不同的端口

accessToken: ""

admin:

addresses: http://localhost:9999/xxl-job-admin # 这里的端口需要跟上文中在xxl-job-admin中配置的端口号一致

executor: # 执行器,负责和xxl-job-admin通信

appName: contract # 执行器名称,在xxl-job-admin中定义执行器时需要使用这里定义的名字。

logpath: D:\tmp\logs # xxl执行器日志存放地址

logretentiondays: 10 # 日志保留多少天

初始化

在这里使用上面的配合信息,构建一个执行器实例。

@Value("${xxl.job.admin.addresses}")

private String adminAddress;

@Value("${xxl.job.executor.appName}")

private String appName;

@Value("${xxl.job.executor.logpath}")

private String logPath;

@Value("${xxl.job.executor.logretentiondays}")

private int logRententionDays;

@Value("${xxl.job.port}")

private int port;

@Bean

public XxlJobSpringExecutor xxlJobExecutor() {

XxlJobSpringExecutor xxlJobSpringExecutor = new XxlJobSpringExecutor();

xxlJobSpringExecutor.setAdminAddresses(this.adminAddress);

xxlJobSpringExecutor.setAppname(this.appName);

xxlJobSpringExecutor.setLogPath(this.logPath);

xxlJobSpringExecutor.setLogRetentionDays(this.logRententionDays);

xxlJobSpringExecutor.setPort(port);

return xxlJobSpringExecutor;

}

Handler

定时任务中的任务,由它来完成真正的工作。

@XxlJob("payCreatorForOld")

public ReturnT<String> updateOldContract(String param) {

List<Contract> contracts = contractService.getOldContract();

contracts.stream().forEach(contract -> {

try {

log.debug("===================>>>>>>>>>");

rocketMQService.syncSend(contract);

} catch (JsonProcessingException e) {

throw new RuntimeException(e);

}

});

XxlJobLogger.log("XXl-job for old "+ param);

return ReturnT.SUCCESS;

}

ThreadPool的使用

//初始化线程池

@Configuration

public class ThreadPoolConfig {

@Bean

public ThreadPoolTaskExecutor executor() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

executor.setMaxPoolSize(2);//线程池最多有2个线程

executor.setCorePoolSize(1);//核心线程数为1

executor.setThreadNamePrefix("*_*");//线程名称前缀

executor.setQueueCapacity(100);//线程池等候队列

executor.setRejectedExecutionHandler(new ThreadPoolExecutor.AbortPolicy());//拒绝策略

executor.initialize();//初始化

return executor;

}

}

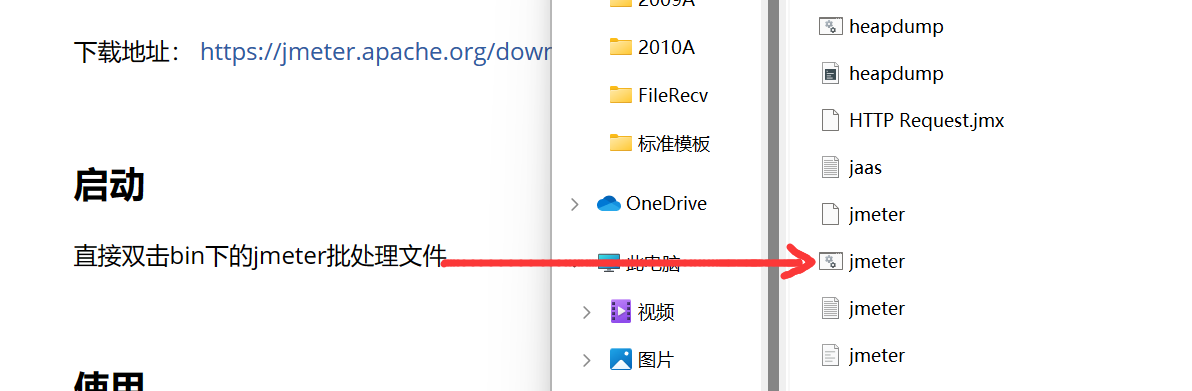

测试JMeter

安装

下载地址: https://jmeter.apache.org/download_jmeter.cgi

启动

直接双击bin下的jmeter批处理文件

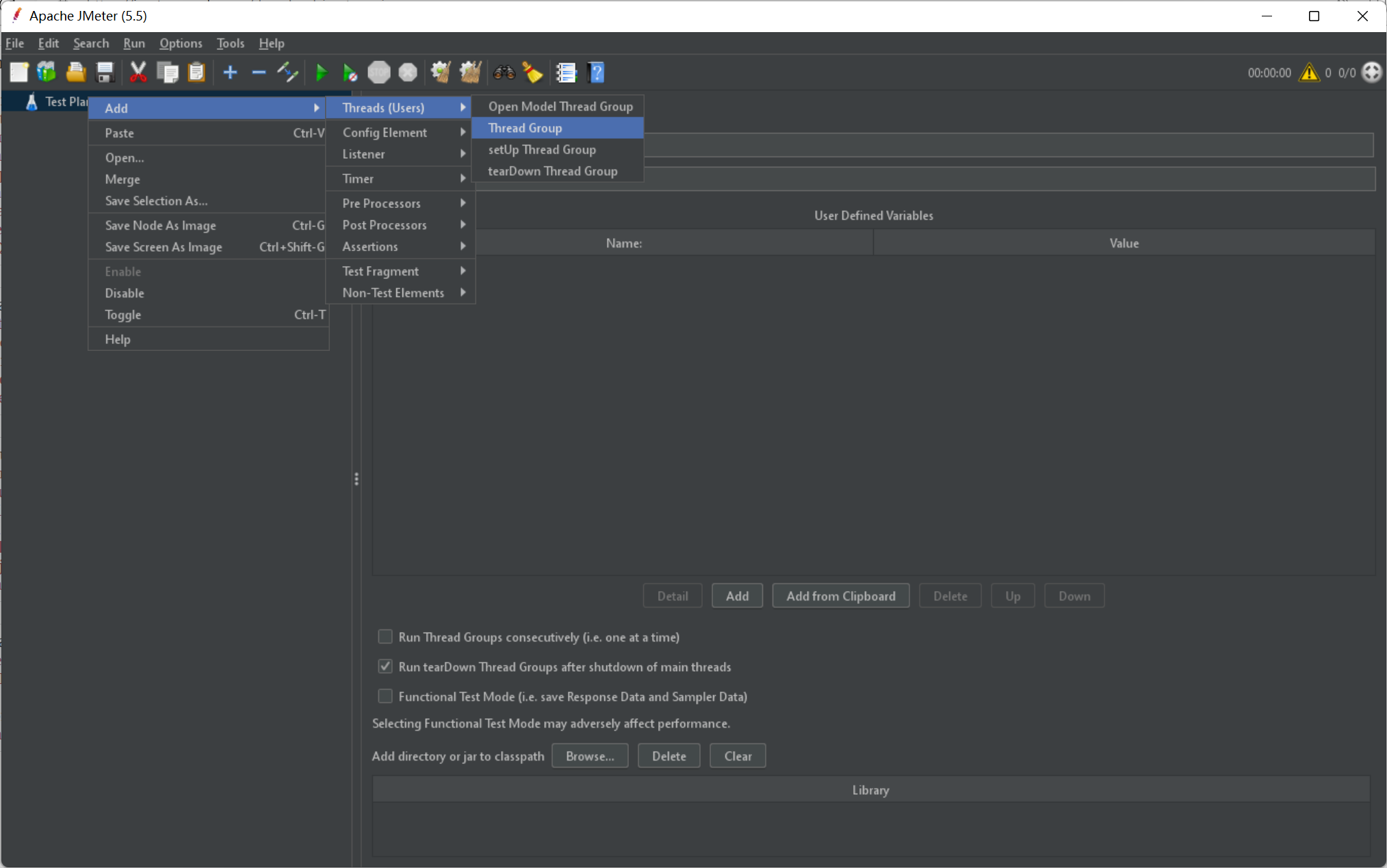

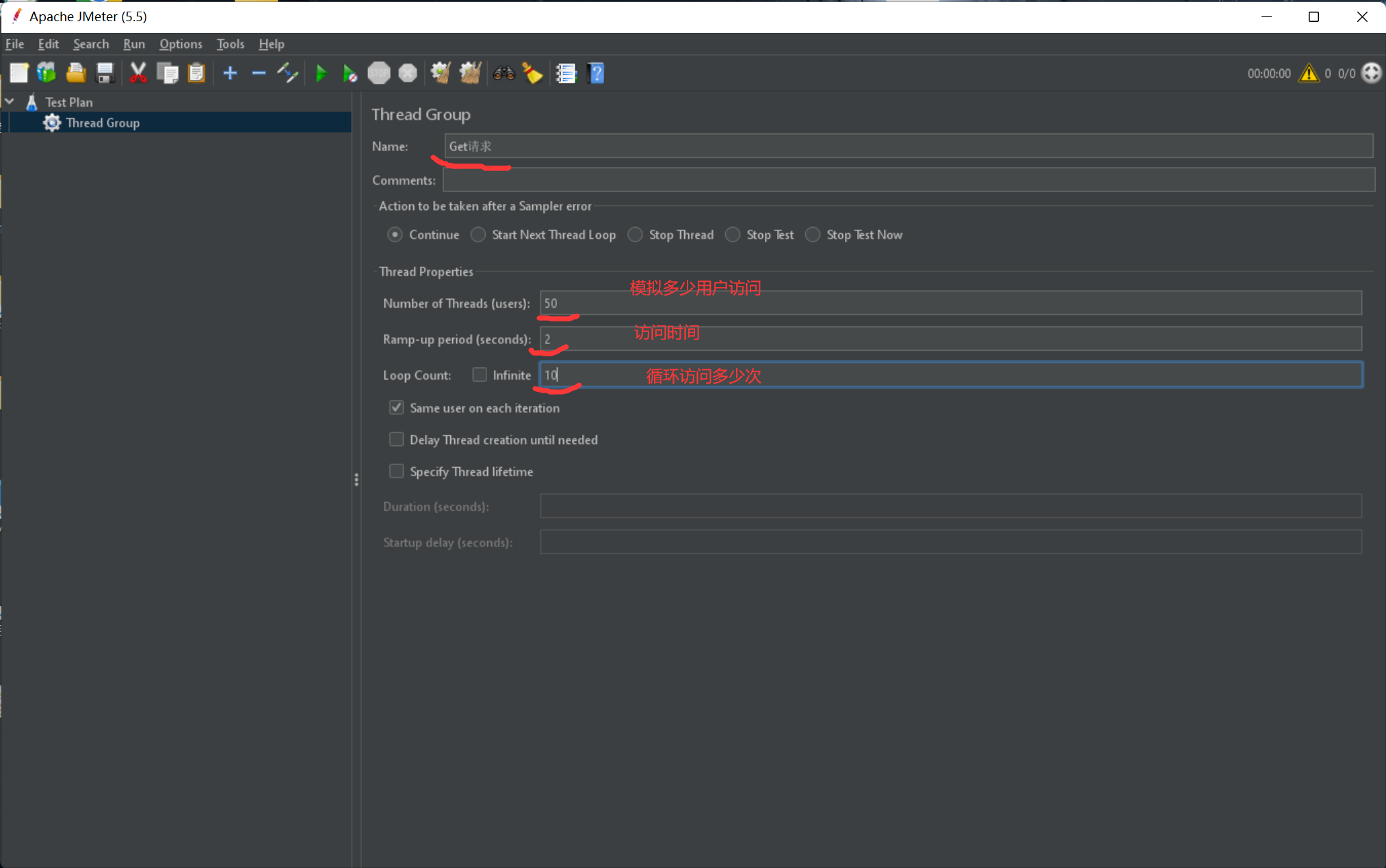

使用

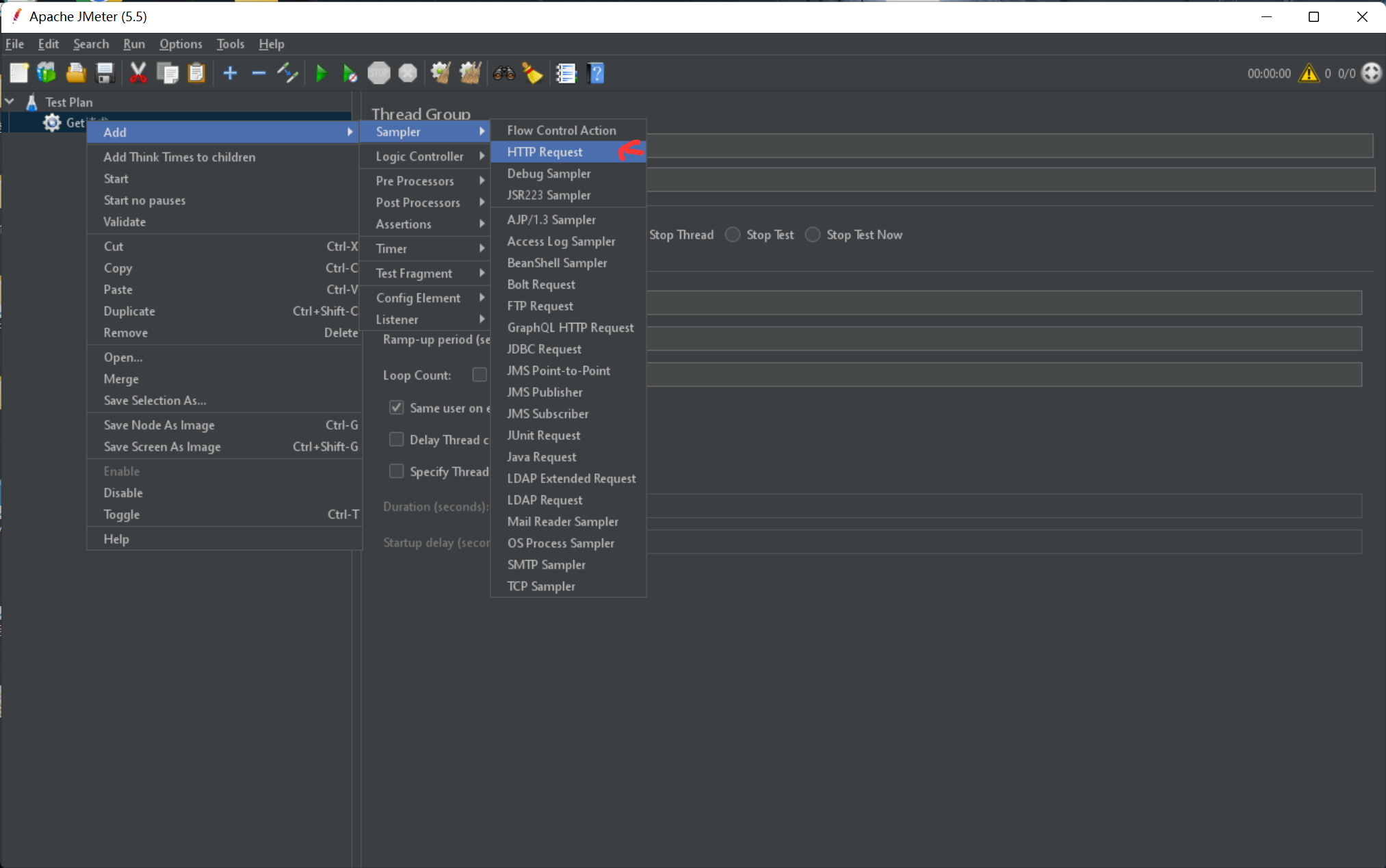

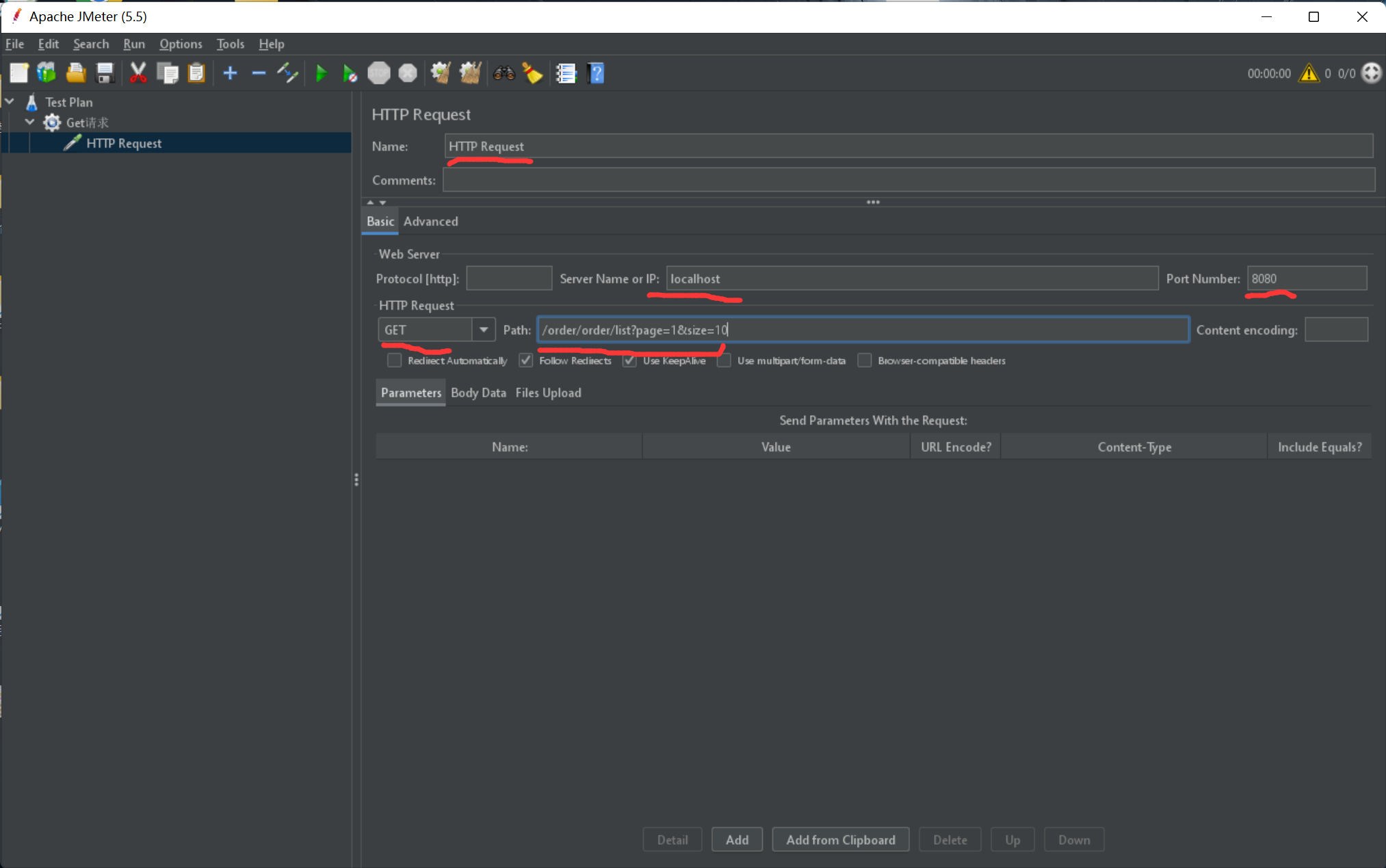

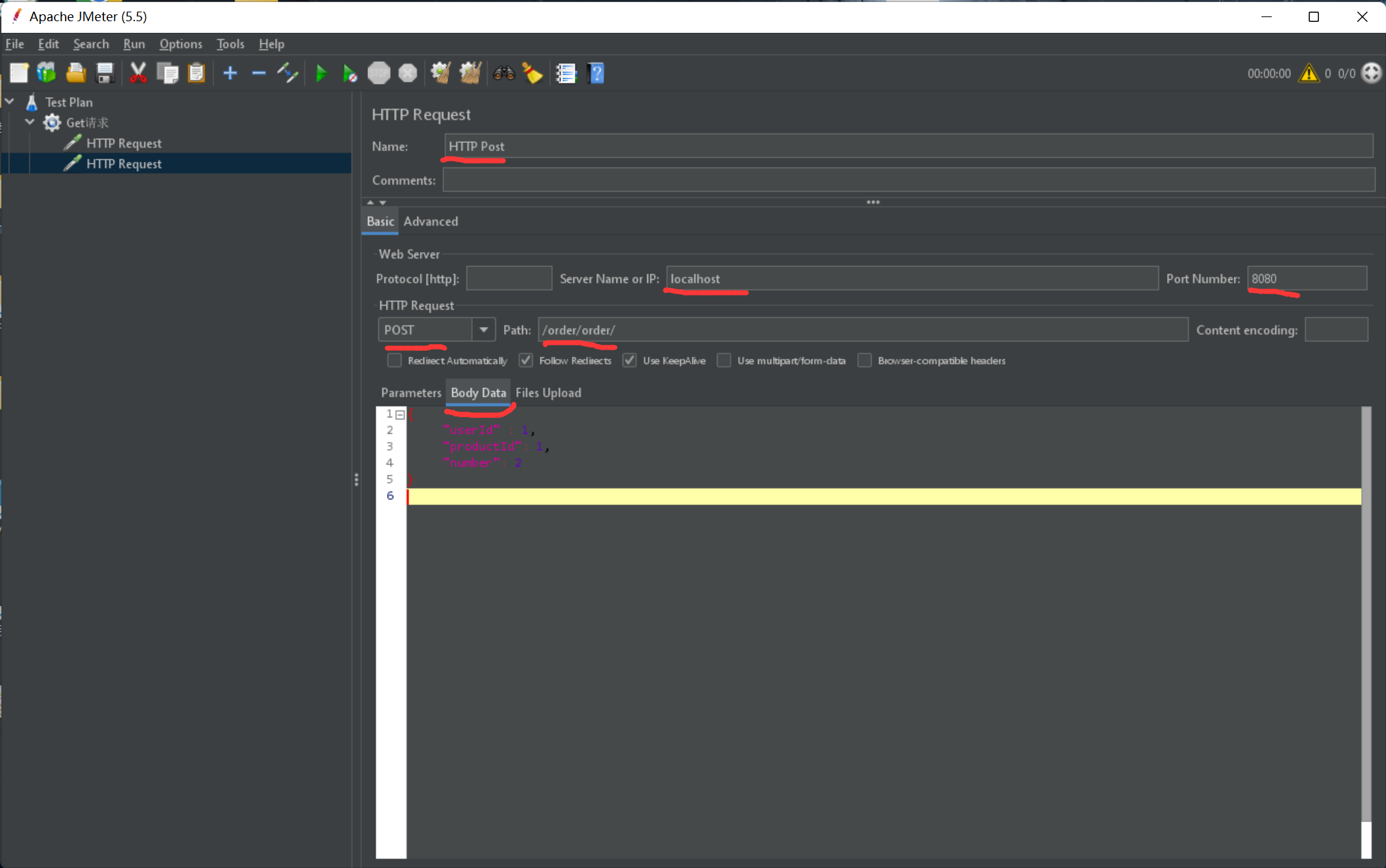

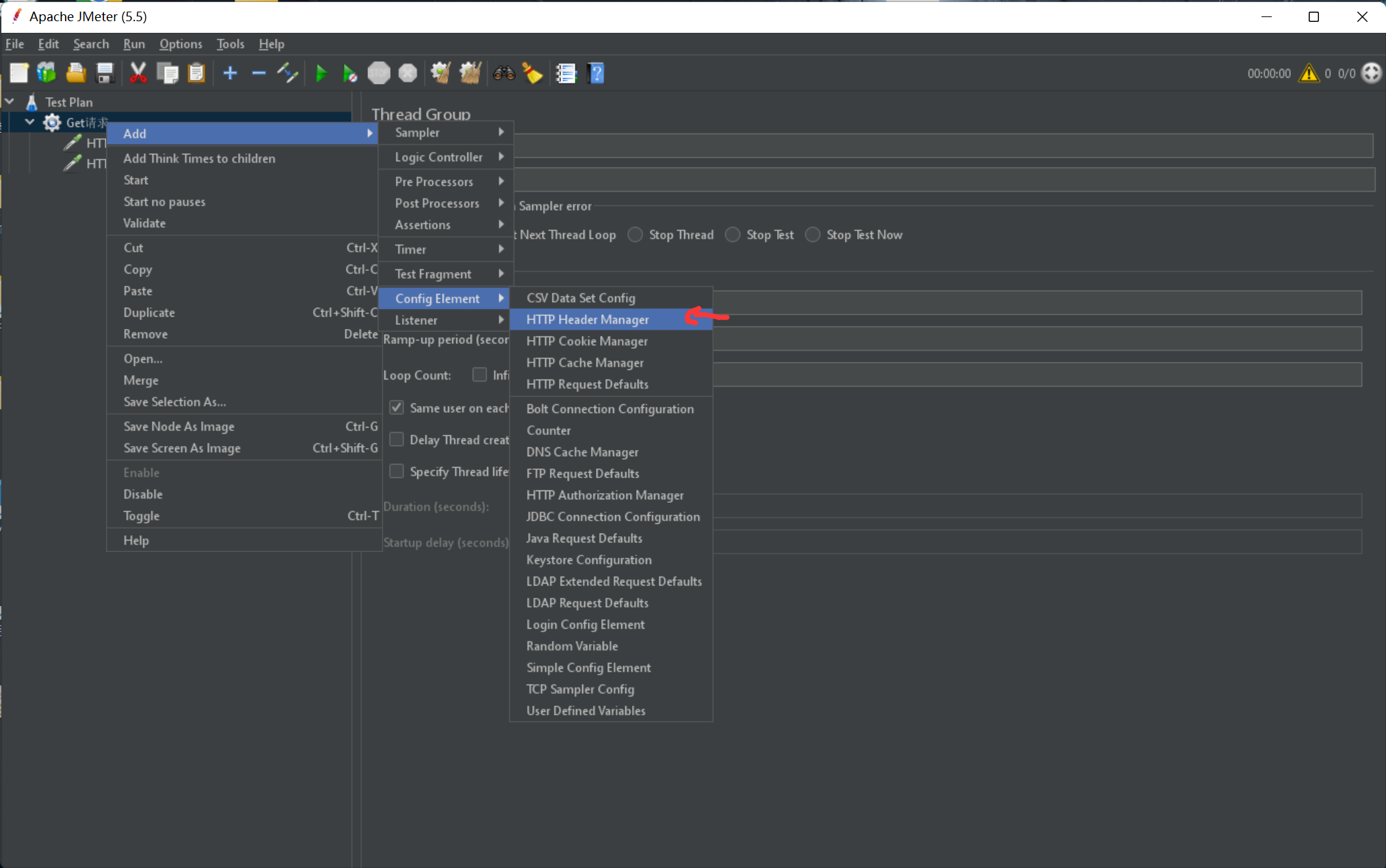

- 新建线程组,模拟用户访问,线程数及模拟用户数

- 配置线程组

- 配置http请求

- 配置httpGet请求信息

- 配置httpPost请求

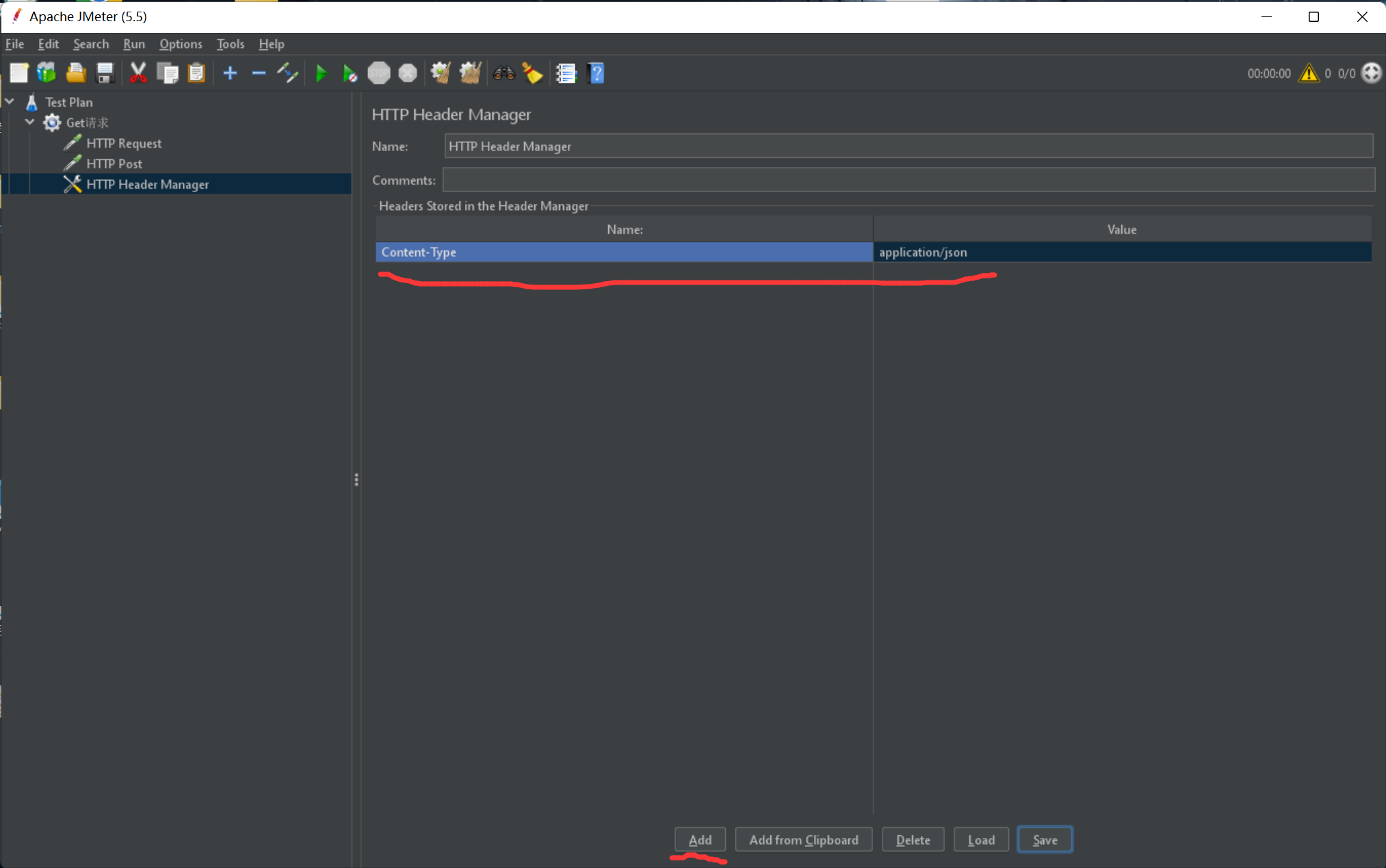

- 配置header

- 提交json数据时header的内容

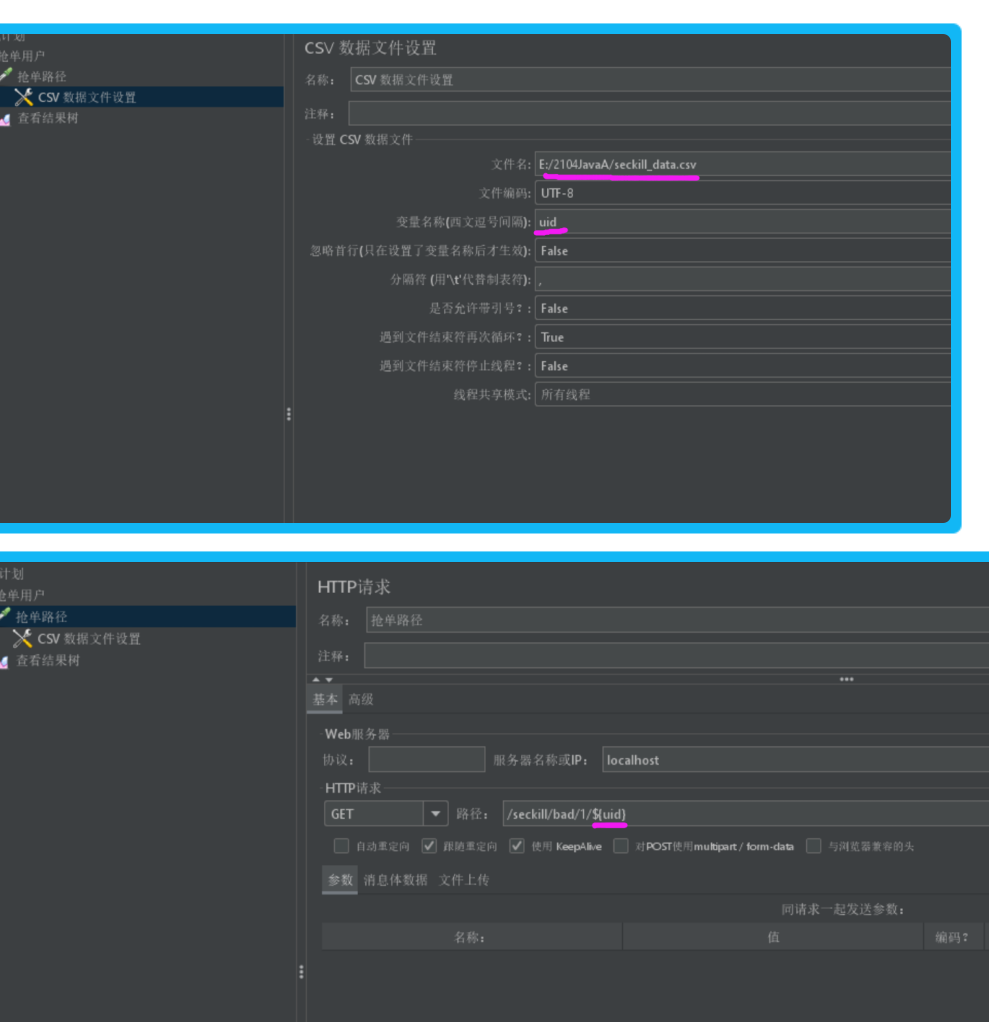

- 动态参数

查看结果

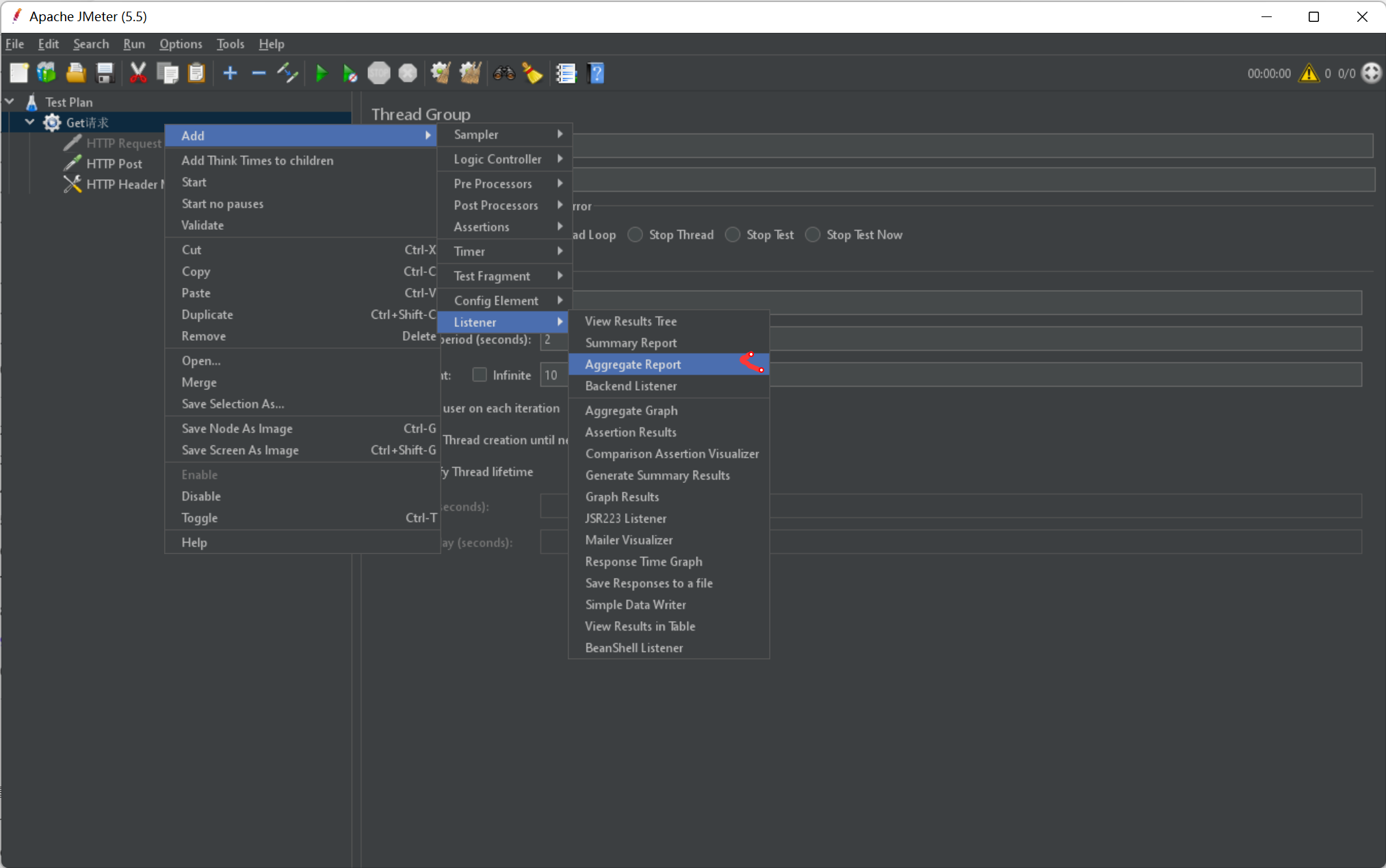

结果聚集:

查看整体测试结果

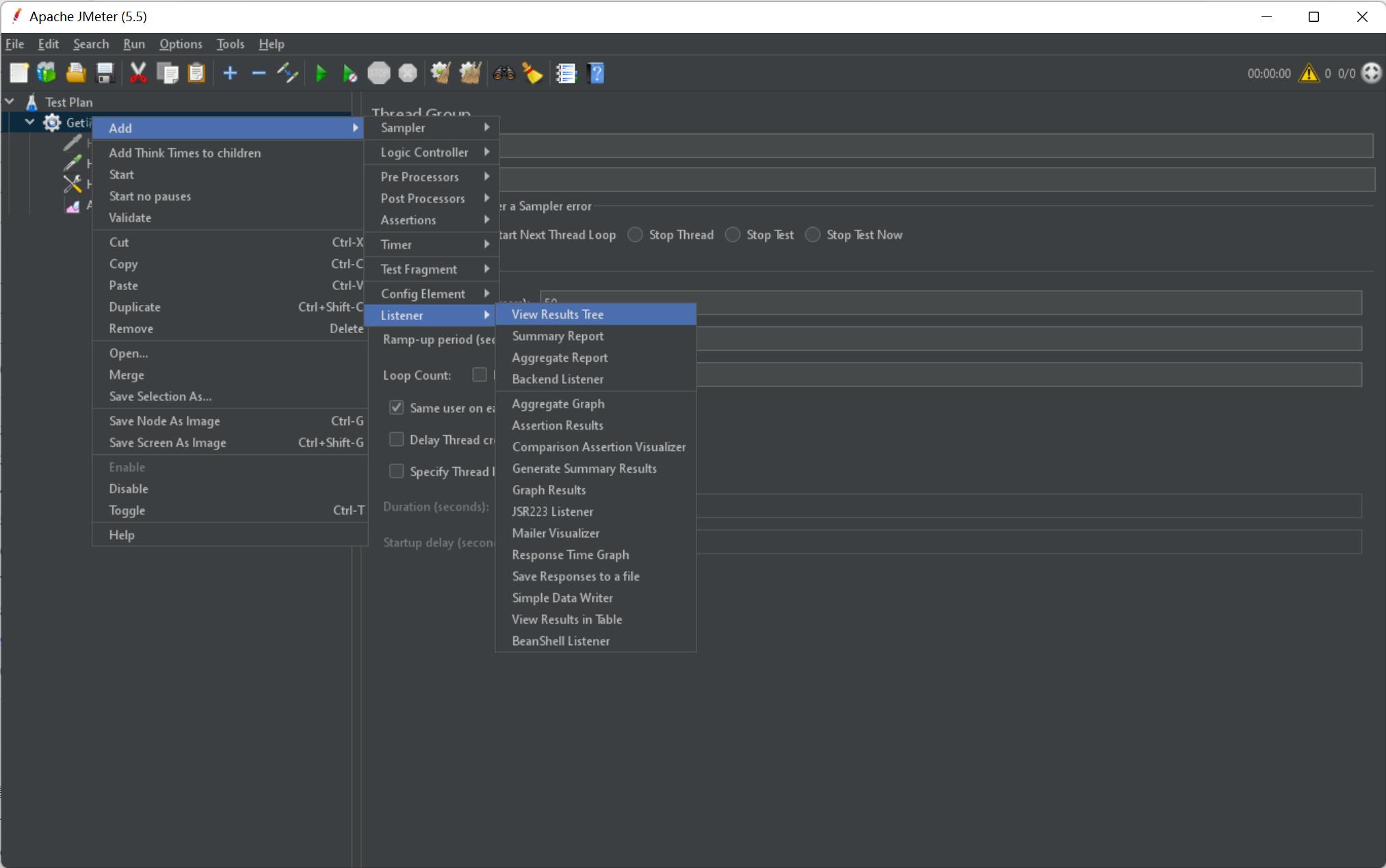

结果树

查看单个情况

命令行测试

bin\jmeter -n -t github.jmx -l testplan\result.txt -e -o testplan\webreport

-n 在命令行模式运行

-t 测试计划文件名称

-l 将结果记录到那个文件

-e 生成仪表板

-o 报告测试地址

合同录入

设计表结构

- 01.1 合理设计表结构至少包括合同表,合同付款计划表,采用spring cloud搭建微服务架构至少包括注册中心,配置中心,网关,合同服务。(要求表及字段命名规范,注释清楚,满足三大范式要求,可以适当运用反范式设计) ??怎么创建付款计划表

- 02.1 合理设计表结构,用户表,患者表,数据字典表等(要求性别,学历,职业统一用数据字典表处理)

- 03.1 合理设计表结构,用户表,企业表,数据字典表等(要求所属行业:来自数据字典表)

- 04.1 合理设计表结构至少包括合同表,合同付款计划表,采用spring cloud搭建微服务架构至少包括注册中心,配置中心,网关,合同服务(要求:Spring Cloud - Eureka注册中心实现高可用功能)。 ??怎么创建付款计划表

服务搭建

- 01.2 Spring Cloud - Eureka注册中心实现高可用功能

- 01.3 Spring Cloud - Gateway网关路由

- 02.2 搭建spring cloud微服务架构,包括注册中心,配置中心,网关,用户服务,患者服务等.(要求:注册中心实现高可用,服务正常启动)

- 02.3 Spring Cloud - Gateway网关路由(要求:前端对服务访问均通过gateway访问;gateway网关配置路由;Gateway网关解决跨域问题)

- 03.2 搭建spring cloud微服务架构,包括注册中心,配置中心,网关,用户服务,企业服务等(注册中心实现高可用,服务正常启动)

- 03.3 Spring Cloud - Gateway网关路由(前端对服务访问均通过gateway访问;gateway网关配置路由;Gateway网关解决跨域问题)

- 03.4 服务监考(使用Admin查看用户服务的准实时日志,并演示实时调整日志等级)

- 04.2 Spring Cloud - Gateway网关路由(前端对服务访问均通过gateway访问;gateway网关配置路由;Gateway网关解决跨域问题)

- 05.6 Spring Cloud - Eureka注册中心(安装Eureka Server组件,并进行配置;启动Eureka Server并验证服务可用性)

- 05.8 Spring Cloud - Gateway网关路由(前端对用户中心,费用等系统的访问均通过gateway进行)

- 06.4 搭建Eureka服务,并将用户,商品等服务注册到Eureka中

- 06.5 使用Spring Cloud Gateway作为服务网关,所有对接口的调用都需要走网关,正确实现跨域配置

- 07.1 完成Eureka服务的搭建和配置,并将用户中心、服务管理系统接入Eureka

- 07.8 搭建网关服务,并合理配置路由,确保用户服务、服务管理服务等

链路追踪

- 01.4 使用Zipkin作为链路追踪的框架,将所有的应用都集成到Zipkin上,并演示应用之间的调用链路和延迟时间等信息。

- 02.4 使用Zipkin作为链路追踪的框架,将所有的应用都集成到Zipkin上,并演示应用之间的调用链路和延迟时间等信息

- 04.3 使用Zipkin作为链路追踪的框架,将所有的应用都集成到Zipkin上,并演示应用之间的调用链路和延迟时间等信息

- 06.6 使用Zipkin作为链路追踪的框架,将所有的应用都集成到Zipkin上,并演示应用之间的调用链路和延迟时间等信息

合同列表

- 01.5 正确分页,要求能够查看每个合同的付款计划列表。

- 02.6 患者列表正确展示(必须包含患者编号),分页正确

- 03.6 企业列表页面(列表正确展示(必须包含企业编号),分页正确)

- 04.5 合同列表(正确分页;用户登录只能查看自己录入的合同信息,非自己录入的不能查看;要求切换不同用户进行展示)

- 04.6 合同列表-搜索功能(根据合同编号精确查询;根据租客名称模糊查询;根据签约和到期日期精确查询)

- 05.1 费用管理 - 列表展示(按照生成日期降序排序;点击某一行可以进入该费用的详情页)

- 06.1 列表展示 使用Vue和ElementUI实现一个商品列表页面,要求包含商品名称、价格、单位、库存等信息,并支持分页

- 07.3 实现服务管理中的列表页,包括列表展示、搜索、分页等功能(完成根据服务类型(精确查询)和服务名称(模糊查询)的查询)

- 08.2 用户可以输入房屋名称进行搜索,后端根据名称过滤查询数据库中的房屋数据,并返回给前端。(缓存搜索列表首页数据,提高页面的响应能力)

- 10.2 2. 在后端实现分页功能,通过接口参数传递页码和每页显示的数量,后端根据这些参数查询数据库,返回相应的结果给前端。(使用Redis缓存第一页的数据,提升系统性能)

@GetMapping("/page/{page}/{size}")

public Result<IPage<Orders>> page(@PathVariable int page, @PathVariable int size) {

IPage<Orders> ipage = new Page(page, size);

if(page == 1) {

System.out.println("=========第一页");

String key = key(page, size);

IPage<Orders> orders = (IPage<Orders>)redisTemplate.opsForValue().get(key);

if(orders == null) {

System.out.println("第一页走数据库");

ordersService.page(ipage); //从数据库中分页读取数据

redisTemplate.opsForValue().set(key,ipage,30, TimeUnit.MINUTES);

return Result.ok(ipage);

}else {

System.out.println("第一页走缓存");

return Result.ok(orders);

}

}else {

System.out.println("其他页走数据库");

ordersService.page(ipage);

return Result.ok(ipage);

}

}

- 09.2 提供一个房屋列表页面,前端可以通过API接口获取所有房屋的数据,并实现分页功能。(确保大数量的情况下,分页性能不受影响)

格式验证:

- 01.6 合同录入 -完成页面原型前端校验(签订日期小于结束日期;签订日期小于结束日期)

<template>

<div class="about">

<el-form ref="form" :model="contract" :rules="rules">

<el-form-item label="开始时间" prop="start">

<el-date-picker v-model="contract.start" type="date"></el-date-picker>

</el-form-item>

<el-form-item label="开始时间" prop="end">

<el-date-picker v-model="contract.end" type="date"></el-date-picker>

</el-form-item>

</el-form>

</div>

</template>

<script>

export default {

name: "AboutView",

data() {

let validateStart = (rule, value, callback) => {

if(this.contract.end == null) {

callback();

}

if(value >= this.contract.end ) {

callback(new Error("开始不能大于结束"));

}else {

callback();

}

};

let validateEnd = (rule, value, callback) => {

if(this.contract.start == null) {

callback();

}

if(value <= this.contract.start) {

callback(new Error("结束不能大于开始"));

}else {

callback();

}

}

return {

contract: {

start: null,

end: null

},

rules: {

start: [

{required: true, message: "不能为空", trigger: 'blur'},

{validator: validateStart, trigger: 'blur'}

],

end:[

{required: true, message: "不能为空", trigger: 'blur'},

{validator: validateEnd, trigger: 'blur'}

]

},

}

}

}

</script>

-